Что такое развал-схождение? Как часто нужно делать развал-схождения

Сход-развал (развал-схождение) – это регулировка колес автомобиля относительно кузова, которая предполагает два этапа: сход и развал. Именно от того, насколько правильно отрегулированы колеса, зависит управляемость машины и, как следствие, Ваша безопасность. Плохое вхождение в поворот, быстрый износ резины – это лишь некоторые последствия неграмотного выполнения развал-схождения.

Ранее регулировка колес производилась при помощи специальных свесов. Однако сегодня на смену им пришли современные стенды, оснащенные оптическими датчиками. Они позволяют провести компьютерную диагностику и получить максимально точные значения.

В этой статье Вы узнаете, что такое сход и развал и зачем они нужны, а также прочтете о том, когда стоит выполнять регулировку угла колес и почему это следует доверить опытному мастеру.

Что такое развал?

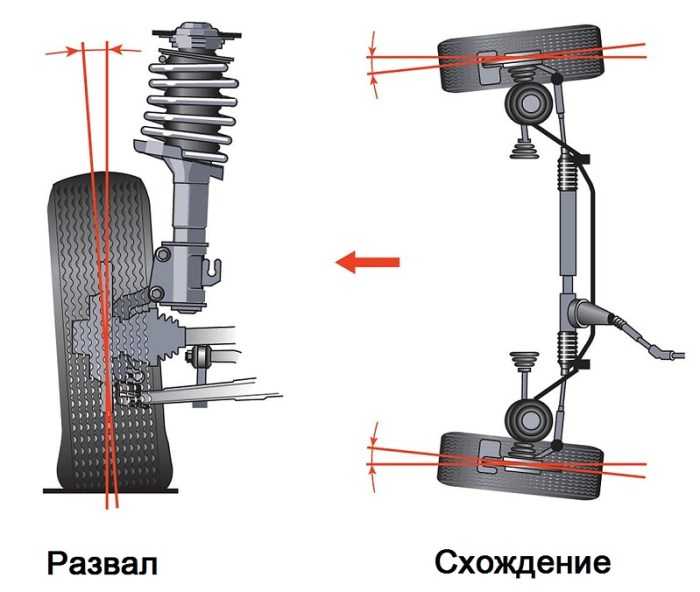

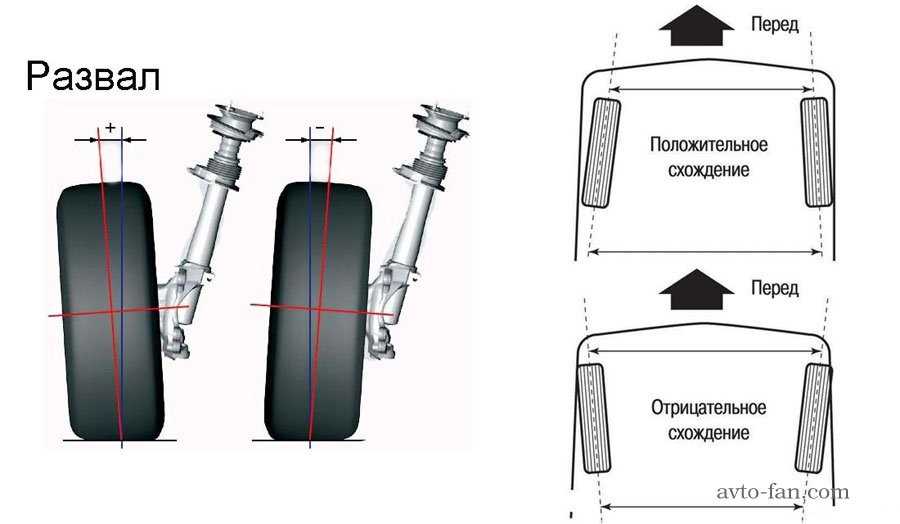

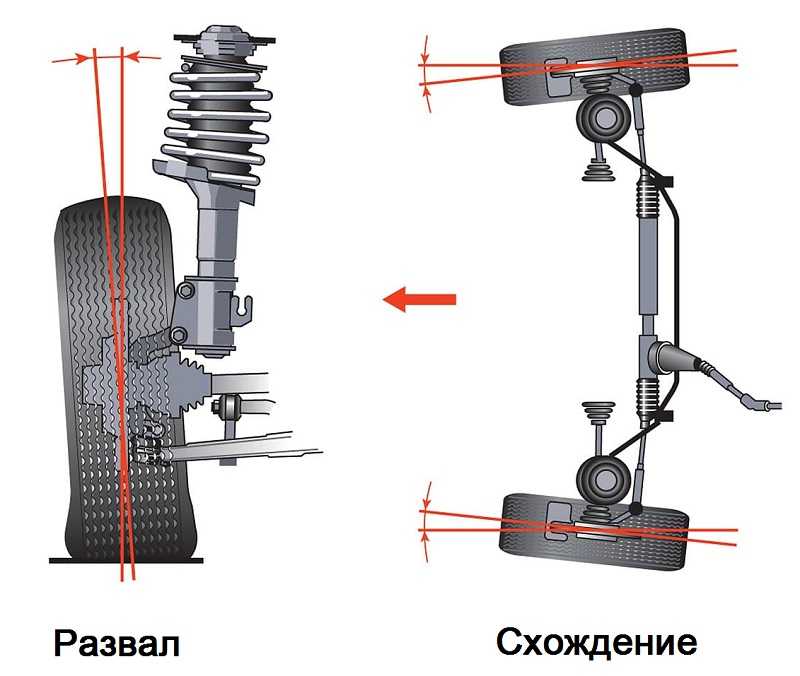

Развалом называют угол, который образуется между плоскостью колеса и вертикальной прямой. Иными словами, это отклонение колеса по вертикали.

Иными словами, это отклонение колеса по вертикали.

Положительный развал отмечается тогда, когда верхние части колес, расположенных на одной оси, находятся дальше друг от друга, чем нижние. Такой развал намеренно настраивается на грузовых автомобилях. Дело в том, что при нагрузке колеса выходят в ноль.

Об отрицательном развале говорят тогда, когда верхние части колес, размещенных на одной оси, находятся ближе друг к другу, чем нижние. Такой развал характерен для спорткаров: он позволяет максимально устойчиво входить в повороты на высокой скорости.

Когда расстояние между верхними и нижними частями колес на одной оси одинаковое, говорят о нулевом развале. Именно в этой ситуации гарантируется минимальный износ резины.

Что такое схождение?

Термином «схождение» обозначают угол между плоскостью вращения колеса и продольным сечением авто. Если передние части колес находятся ближе друг к другу, чем задние, отмечается положительное схождение

. Если задние части колес находятся ближе друг к другу, чем передние, говорят об отрицательном схождении.

Если задние части колес находятся ближе друг к другу, чем передние, говорят об отрицательном схождении.Неправильное схождение гораздо больше влияет на износ шин, чем неправильный развал.

Как понять, что регулировка углов установки колес (передних или задних) неправильная?

Неправильный сход-развал дает о себе знать следующими признаками:

- Колеса «визжат» при прохождении поворотов даже на небольшой скорости.

- Чтобы автомобиль двигался прямо, руль нужно немного отклонить влево или вправо.

- Если Вы отпустите руль, то машина начнет двигаться вправо или влево.

- Резина очень быстро изнашивается.

- Руль плохо возвращается в первоначальное положение после прохождения поворота.

На что влияет сход-развал?

Правильно отрегулированный угол колес обеспечивает Вашему автомобилю устойчивость на любом покрытии и образцовую управляемость. Также минимизируется износ шин, снижается вероятность заноса и повышается топливная экономичность.

Последствия неправильного развала-схождения

Неопытные автолюбители нередко решают справиться с проблемой самостоятельно. Специалисты крайне не рекомендуют так делать, поскольку от Ваших действий зависит безопасность всех участников дорожного движения.

Если на сухом полотне авто остается более-менее управляемым, то на мокром или обледенелом покрытии его сильно «заносит» вправо и влево. Чтобы удержать машину, приходится постоянно корректировать направление движения рулевым колесом. Такое непредсказуемое поведение существенно повышает вероятность ДТП. Кстати, неправильная настройка углов колес довольно часто становится причиной выезда транспортного средства на встречную полосу и серьезных аварий.

Когда делать развал-схождение колес?

Эксперты советуют выполнять регулировку углов колес каждые 20 тысяч километров пробега. Выполнить развал-схождение внепланово придется после:

- Попадания колеса в большую яму, что привело к деформации диска.

- Изменения дорожного просвета вследствие установки укороченных пружин или «домиков».

- Замены шаровых опор, рулевого наконечника, ШРУСа.

А вот после замены шин, стабилизаторов и амортизаторов выполнять развал-схождение необязательно.

Как делают сход-развал?

Прежде чем приступить к регулировке угла колес, опытный мастер выполняет ряд подготовительных мероприятий:

- Осмотр авто, диагностика ходовой части и проверка давления в шинах.

- Определение компенсации биения обода колеса.

- Общая диагностика геометрии ходовой части. На этом этапе специалист выявляет дефекты, которые влияют на управляемость и устойчивость авто вне зависимости от развала-схождения.

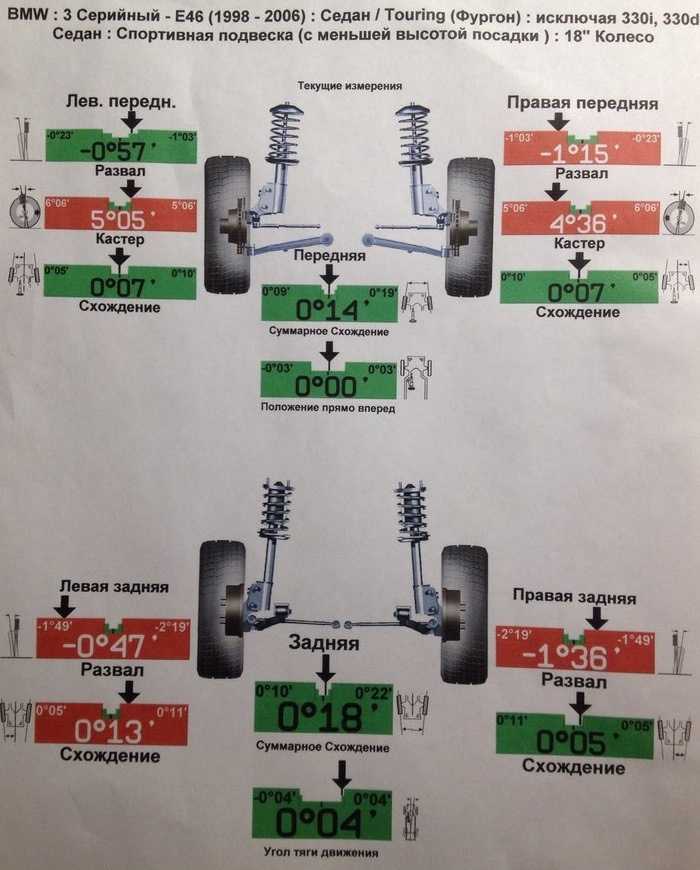

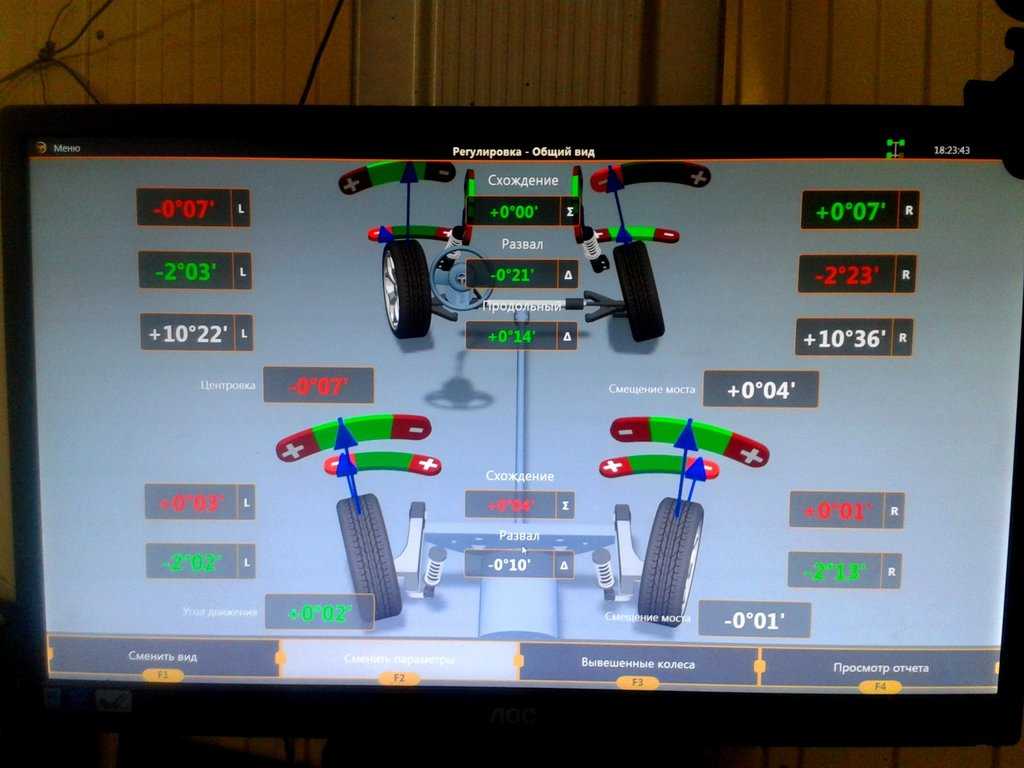

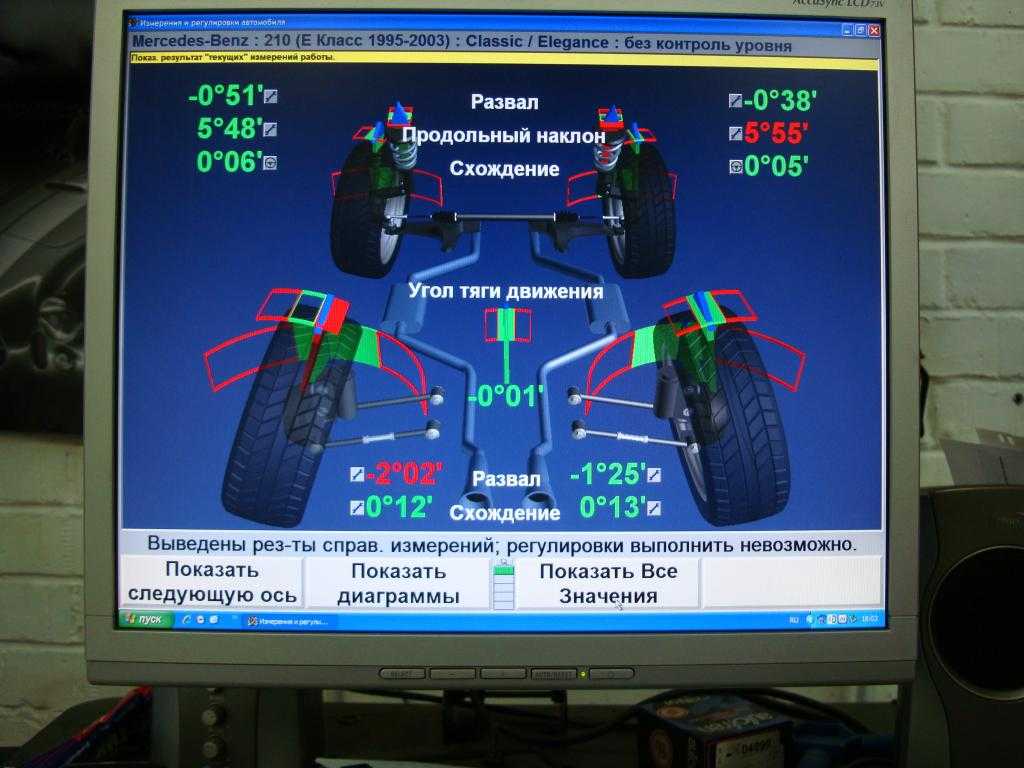

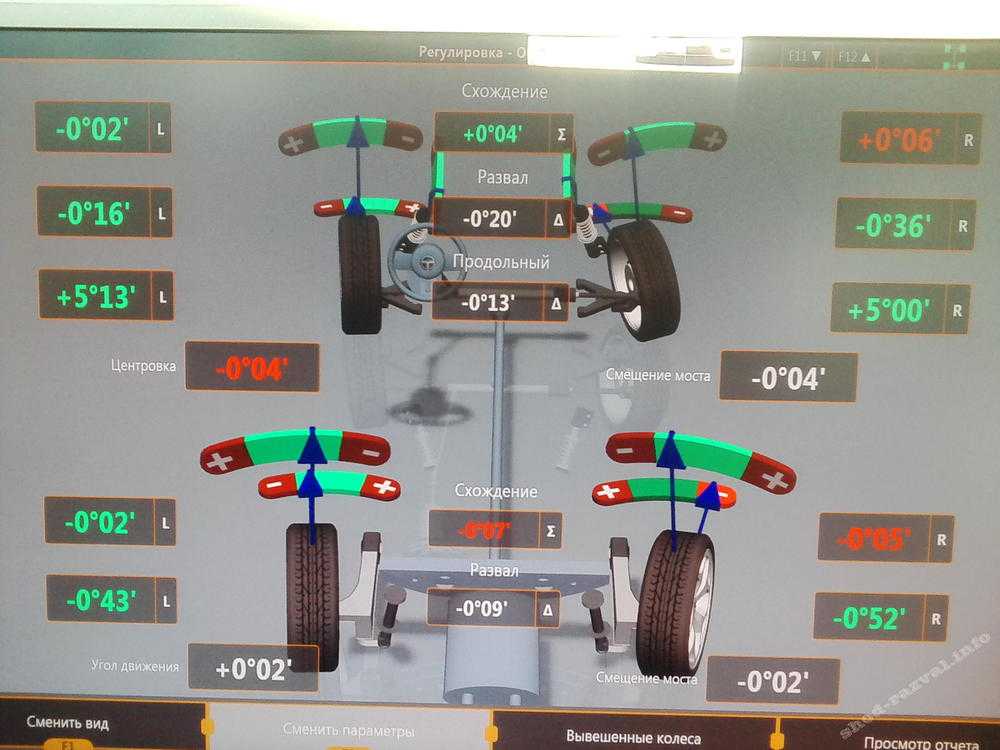

Если автомобиль успешно прошел все испытания, осуществляется регулировка развал-схождения при помощи современного оборудования. По окончании манипуляций Вы получаете распечатку с характеристиками: угол развала правого и левого колеса (для обеих подвесок) и угол схождения, угол движения авто и др.

Полный комплекс услуг по техническому обслуживанию автомобилей (в том числе и регулировка развала-схождения) оказывают специалисты автосервисов официального дилера Peugeot FAVORIT MOTORS. В нашем распоряжении – инновационная техническая база и профессиональный инструмент. Все мастера техцентров прошли аттестацию Peugeot. При выполнении работ мы используем только оригинальные запчасти и расходные материалы и руководствуемся установленным производителем регламентом. К Вашим услугам – доступные цены, интересные акции и программа лояльности.

Как делается развал-схождение осей автомобиля

Узнать о том, как делать развал-схождение, мечтают многие автомобилисты, волею судьбы оказавшиеся за городом. Что делать им, если они оказались там, где нет стенда для регулировки колёсной базы и ничего о нём даже не слышали. А знаете ли вы, что буквально несколько лет назад развал проводился своими руками и являлся обыденной операцией на автомобиль.

Регулировка развала-схождения в автосервисе

Содержание

- Информация, которую обязательно нужно знать

- Для чего это нужно

- Параметры, которые обязан знать каждый водитель

- Поперечный и продольный угол

- Инструкция — как провести операцию своими руками

- Угол схождения колёс и его регулировка

- Когда нужно проводить регулировку угла?

- Подвеска

- Новые пружины

- Клиренс

Информация, которую обязательно нужно знать

Если вдруг вы оказались в далёком населённом пункте, где отсутствует автосервис, и произошла поломка, не отчаивайтесь. Даже если нужно будет собственноручно заменить амортизатор или отремонтировать подвеску, после чего провести обязательно развал-схождение колёс, воспользовавшись этой инструкцией, можно всё проделать самому.

В первую очередь необходимо будет найти какой-нибудь гараж. Подойдёт, например, помещение бывшего совхоза, где, правда, стенда не отыскать, но линейку, хоть и стародавнюю, для регулировки угла схождения найти будет можно.

Для чего это нужно

Прежде чем провести операцию, следует знать, а зачем это нужно. Разве нельзя, не регулируя угла, доехать до ближайшего города, где в автосервисе опытные мастера за дело возьмутся? Оказывается, всё не так просто. Доехать можно, но вот каким образом? Неправильный развал приведёт к тому, что даже несколько километров езды способны привести к облысению протектора на одном колесе.

Что такое положительный и отрицательный развал-схождение

Параметры, которые обязан знать каждый водитель

Что такое развал? Не каждый автомобилист, даже проехавший много километров, это знает. А между прочим, развалом колёс называют угол, находящийся поперёк плоскости вращения и вертикалью колеса. Если этот угол будет меньше нормального значения, колесо будет направлено внутрь вертикали верхней части. Если же угол будет больше, колесо будет смотреть наружу, относительно вертикали.

Что касается схождения колёс, то им называют угол, находящийся между плоскостью вращения колеса и направления движения. Измеряется такой угол в градусах или же в миллиметрах.

Поперечный и продольный угол

Кроме вышеописанных параметров, водитель должен знать и о различных углах наклона оси.

Так, поперечным углом наклона называется величина, которая измеряется между проекцией оси поворота относительно вертикали поперечной плоскости колеса.

Напротив, продольным углом наклона оси называют величину, которая находится между вертикалью и проекцией оси поворота колеса на продольной плоскости. Такой угол ещё называют кастром, и он должен быть равен 6 градусам. И после проведения правильной регулировки кастр обеспечит самовыравнивание колёс за счёт скорости.

Инструкция — как провести операцию своими руками

Стенд регулировки развала-схождения

Для проведения операции понадобятся следующие инструменты и составляющие:

- стандартный набор инструментов автомобилиста;

- ровная бетонная площадка, желательно со смотровой ямой;

- шнур-отвес;

- линейка;

- мел.

Для начала выставляем колёса в положение прямо. Регулируем рулевым колесом, стоя сбоку автомобиля и следя за колёсами. Делаем мелом отметки сверху и снизу колеса по диаметру.

Далее, берём шнур-отвес и прикладываем его к крылу, измеряя расстояние от верхнего и нижнего края диска до места прикладывания отвеса.

Разница между величинами расстояния должна быть равной плюс/минус 3 мм.

После этого нужно будет прокатить автомобиль немного вперёд так, чтобы меловые метки повернулись на 90 градусов. Снова повторяем замер, таким же образом, как и ранее.

В видео рассказывается о том, что такое развал-схождение и как происходит регулировка:

Эта повторная процедура проводится в целях чистоты замера, ведь ни крыло, ни площадка, ни само колесо идеально ровной точкой отсчёта считаться не может.

После этого нужно будет снять колесо.

После чего колесо и кронштейн ставим на место.

Проведённая процедура поможет правильно установить угол развала колеса. И даже здесь погрешности разрешаются, но они должны быть следующими:

- на заднеприводные автомобили +1…+3 мм;

- на переднеприводные модели −1…+1 мм.

Угол схождения колёс и его регулировка

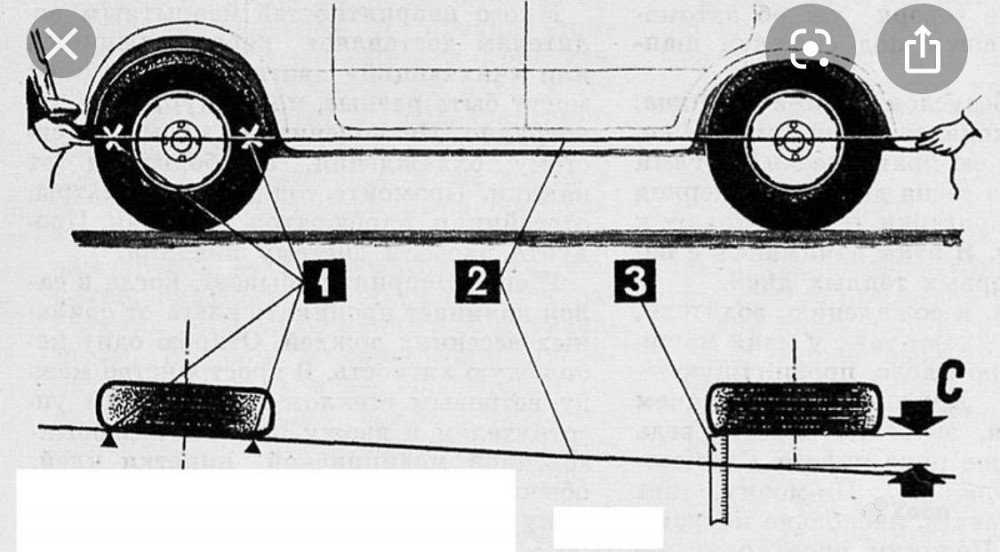

Сход-развал проводят и путём регулировки схождения колёс. Для этого используют специальную телескопическую линейку. Опять же нужно работать на идеально ровной площадке и установить колёса в направлении «прямо».

Теперь уже на внутренней стороне покрышки, ближе к диску, ставим метки мелом. Устанавливаем линейку таким образом, чтобы она не касалась никаких деталей подвески, кузова и т. п., но упиралась концами в метки. Затем линейку фиксируем. При этом «0» нужно будет сопоставить с неподвижным указателем шкалы.

При этом «0» нужно будет сопоставить с неподвижным указателем шкалы.

Видео — как правильно делается развал-схождение:

Автомобиль прокатываем немного вперёд, и линейка смещается при этом назад, опять же не касаясь никаких деталей. Проверяем показания. Если расстояние между колёсами стало меньше, нужно укоротить рулевые тяги. Если же стало больше, рулевые тяги нужно удлинить. Длина тяг регулируется с помощью специальной муфты.

Проведённая таким образом регулировка позволит благополучно добраться до ближайшего автосервиса.

Когда нужно проводить регулировку угла?

Вышеописанная инструкция поможет провести самостоятельно замеры и регулировку. Но знать, когда нужно проводить такую операцию, тоже очень важно.

Обычно после замены любой детали подвески автомобиля эта операция должна быть проведена. Незаметный невооружённым глазом крен вызывает, к примеру, замена верхней опорной чашки даже одной стойки. Около двух миллиметров даёт такой крен, а это уже повод к незамедлительной операции по регулировке угла.

Около двух миллиметров даёт такой крен, а это уже повод к незамедлительной операции по регулировке угла.

Если есть возможность, то автомобиль следует регулярно ставить на стенд, где специалисты проведут необходимые измерения. Незаметные на ощупь люфты и многое другое мастер на таком стенде быстро найдёт и предложит провести соответствующие работы.

Подвеска

Подвеска автомобиля — важная его деталь. И если даже вы ничего с ней не делаете и ездите сверхаккуратно, всё равно со временем она просядет. Из-за этого уменьшится дорожный просвет. Сама подвеска устроена таким образом, что от положения колеса будет зависеть и угол схождения и развала. Поэтому раз в год, обычно весной, опытные водители всегда проверяют и при необходимости регулируют угол развала.

Новые пружины

В случае если на автомобиль были поставлены новые пружины, развал следует отрегулировать сразу же после ремонта. А потом опять через месяц. Это делается из-за того, что дорожный просвет за это время уменьшается на два-три сантиметра. И желательно менять пружины до зимы, чтобы из-за постоянно меняющихся углов развала свести к минимуму износ протектора.

И желательно менять пружины до зимы, чтобы из-за постоянно меняющихся углов развала свести к минимуму износ протектора.

Клиренс

Регулировку углов развала следует проводить и после изменения клиренса с помощью проставок или других приспособлений. После того как колёса сменяются на размер больше или меньше, проводить развал не нужно, так как от этого углы не меняются. Но ставить на автомобиль колёса или диски разного размера крайне не рекомендуется!

Кроме того, развал-схождение принято делать, после того как на автомобиль и его заднюю ось было установлено тяжёлое оборудование весом 30 кг и больше. Или в случае когда был установлен груз весом 100 кг на переднюю ось, регулировка углов также должна быть проведена.

Вышеописанная инструкция поможет не только научиться делать развал своими руками, но и неплохо сэкономить. Как известно, цена на такие услуги в автосервисах высокая. Хотя раз год можно провести осмотр на 3D-стенде развала-схождения, где специалисты выявят неисправности.

что это, когда и как часто делать, сколько стоит регулировка углов установки колес, можно ли делать ее самому

Эдуард Солодин

недавно делал сход-развал

Профиль автора

Развал, схождение и кастер — три основных параметра углов установки колес.

Они основные, потому что их несложно проверить и отрегулировать. Есть много других. Например, аккерман — разница радиусов поворота правого и левого колеса. Дополнительные параметры углов в основном регулируют на спортивных автомобилях.

Углы установки колес влияют на устойчивость и управляемость автомобиля, а значит, на комфорт и безопасность водителя и пассажиров. Последнее особенно важно: машину с неправильными углами установки колес при экстренном торможении может увести в сторону, а системы стабилизации могут работать некорректно. Самая безобидная и частая проблема — страдает резина. Весной она опять сильно подорожала, поэтому за этим стоит следить еще тщательнее, чем раньше.

В этой статье я расскажу, что такое развал, схождение и кастер, как часто нужно регулировать углы установки колес, по каким признакам можно понять, что их параметры изменились. Кроме того, я отвечу на вопросы, можно ли сделать сход-развал самостоятельно и как выбрать хороший автосервис.

Что такое углы установки колес и на что они влияют

Развал — угол между плоскостью вращения колеса и вертикалью. Увидеть неправильный развал можно спереди или сзади машины.

Положительный развал — когда верхняя часть колеса выступает наружу относительно ступицы. Автомобиль с таким развалом с завода — это скорее всего грузовик или какая-нибудь спецтехника. Под нагрузкой колеса встают перпендикулярно плоскости дорожного полотна, развал становится нулевым.

Отрицательный развал — когда нижняя часть колеса выступает наружу относительно ступицы. Автомобиль с таким развалом более устойчив в поворотах.

Схождение — угол между плоскостью вращения колеса и продольной осью автомобиля. Неправильное схождение видно сверху или снизу автомобиля.

Неправильное схождение видно сверху или снизу автомобиля.

Положительное схождение — когда передняя часть колес обращена внутрь. Отрицательное — когда наружу.

Может показаться, что схождение должно быть нулевым, но это не так. Если сделать отрицательный развал и не компенсировать его отрицательным схождением, внутренняя сторона покрышки износится очень быстро.

/auto-album-2/

«В ее подстаканник помещается ряженка»: еще 10 автомобилей, которые мы любим всей душой

Кастер — это угол между осью поворота колеса и вертикалью. Еще его называют продольным углом наклона.

Положительный кастер — когда колесо ближе к передней части машины, чем к точке крепления стойки. Он помогает автомобилю стабилизировать управляемые колеса при наборе скорости. Проще всего представить положительный кастер на дорожном велосипеде: если набирать скорость и отпустить руль, велосипед поедет прямо. Положительный кастер — норма для современных автомобилей: особенность в том, что угол этот обычно небольшой: чаще до 6°, но может доходить до 10°.

Отрицательный кастер — когда колесо ближе к точке крепления стойки, чем к передней части машины. Такой кастер у продуктовой тележки: он позволяет колесам легко крутиться вокруг своей оси, благодаря чему ее проще поворачивать в любую сторону.

Отрицательный кастер был у большинства старых автомобилей, например у Волги ГАЗ-21. Так удавалось добиться относительно комфортного управления на скорости в условиях отсутствия гидроусилителя руля. Управляемые колеса в то время стабилизировали за счет другой конструкции шин.

/7-first-auto/

«Дарит эмоции, а все остальное решаемо»: 7 историй о первом автомобиле

Автопроизводители нормируют параметры углов установки колес с учетом множества факторов: конструкции и жесткости подвески, пятна контакта с дорогой, вылета колеса, размеров шин. Настройки могут различаться даже у автомобилей одной модели — в зависимости от комплектации и типа подвески.

Какие углы можно отрегулировать, а какие нет

Не во всех автомобилях можно отрегулировать все углы колес. Например, если на задней оси автомобиля балка или мост, то углы задних колес не отрегулировать. Со временем они все равно изменятся по причине деформации балки. Иногда проблему пытаются решить с помощью специальных проставочных шайб под ступицу или берут другую балку с разборки, но помогает это далеко не всегда. Самый надежный, но дорогой способ — заменить старую балку на новую оригинальную.

Например, если на задней оси автомобиля балка или мост, то углы задних колес не отрегулировать. Со временем они все равно изменятся по причине деформации балки. Иногда проблему пытаются решить с помощью специальных проставочных шайб под ступицу или берут другую балку с разборки, но помогает это далеко не всегда. Самый надежный, но дорогой способ — заменить старую балку на новую оригинальную.

На подвеске типа «макферсон» в большинстве случаев не отрегулировать развал. Такая подвеска стоит на большинстве современных автомобилей.

Кастер — это исключительно про управляемые колеса, то есть почти всегда на передней оси. На задней кастер обычно нулевой. Тем не менее он может измениться после ДТП или ремонта с применением неоригинальных запчастей. Исключение — машины, у которых задняя ось может подруливать: кастер есть как параметр, но вряд ли его можно отрегулировать.

/guide/how-to-buy-new-autoparts/

Как покупать новые запчасти и расходные материалы для машины

Как делают развал-схождение

Сначала специалист должен убедиться, что подвеска полностью исправна, а давление в шинах в норме и одинаковое для колес одной оси. На разных осях оно может незначительно различаться. Обычно норму для конкретного автомобиля указывают на специальной наклейке в дверном проеме или на лючке бензобака.

На разных осях оно может незначительно различаться. Обычно норму для конкретного автомобиля указывают на специальной наклейке в дверном проеме или на лючке бензобака.

Если не выровнять давление в шинах, машину будет утягивать в сторону колеса с меньшим давлением, даже если правильно выставить углы колес. Также бесполезно регулировать углы установки колес на машине с разбитыми шаровыми или порванными сайлент-блоками рычагов.

Также не стоит выполнять эту операцию перед очередной сменой шин — развал-схождение делают на сезонной резине, так что позаботьтесь о «переобувке» заранее.

/guide/shina-s-probegom/

Как купить б/у шины для легкового автомобиля

Некоторые автомобили перед настройкой надо нагрузить. На СТО для этого часто используют канистры с водой или песком, необходимая нагрузка указана в руководстве по эксплуатации авто.

Колеса на стенде для схождения-развала наезжают на специальные поворотные круги — «пятаки», они нужны, чтобы снять нагрузку с подвески. При этом колеса не висят в воздухе: они под нагрузкой и могут менять угол. Пятаки должны свободно двигаться вдоль оси колес и вращаться. Точность измерений и качество настройки серьезно пострадают, если пятаки тяжело сдвинуть: так бывает, если они заржавели или забились песком.

При этом колеса не висят в воздухе: они под нагрузкой и могут менять угол. Пятаки должны свободно двигаться вдоль оси колес и вращаться. Точность измерений и качество настройки серьезно пострадают, если пятаки тяжело сдвинуть: так бывает, если они заржавели или забились песком.

На колеса надевают «мишени» — специальные датчики с зеркалом или стеклом. На них направляется камера и считывает положение колеса. Мишени с зажимами на колесный диск монтируются дольше и могут поцарапать металл. Более безопасный вариант — мишени с зажимами на шине.

После мастер заносит в программу развального стенда данные об автомобиле: марку, модель, поколение и комплектацию. Так стенд подстраивается под конкретный автомобиль и специалист понимает, какие углы необходимо выставить. На автомобилях с пневмоподвеской для корректного расчета углов установки колес важно измерить и внести в программу клиренс каждого колеса.

На колесном диске крепят мишень. Пятак на этом фото — прямо под колесом. Фото: Singkham / ShutterstockДалее специалист следует инструкции программы. Чтобы рассчитать угол развала колес, автомобиль прокатывают немного назад и возвращают на место. Затем вращают руль влево и вправо, чтобы программа рассчитала угол схождения. Педаль тормоза и руль после этого блокируют, чтобы убрать погрешность при настройке. Руль должен стоять ровно посередине относительно рулевой рейки.

Чтобы рассчитать угол развала колес, автомобиль прокатывают немного назад и возвращают на место. Затем вращают руль влево и вправо, чтобы программа рассчитала угол схождения. Педаль тормоза и руль после этого блокируют, чтобы убрать погрешность при настройке. Руль должен стоять ровно посередине относительно рулевой рейки.

Если углы колес выбиваются из нормального диапазона, программа сообщит об этом и выделит расхождение красным цветом.

/ford-focus-2021/

Как я купила 15-летний Форд Фокус

На рулевых тягах и наконечниках есть резьба. Если увеличивать или уменьшать их длину, можно отрегулировать схождение колес. Мастер с помощью ключей регулирует положение колес и видит на мониторе, как меняются параметры. Настройка настолько точная, что имеют значение не только градусы, но и их доли — минуты. После правильной настройки все углы колес должны находиться в зеленой зоне.

Актуальные и допустимые значения развала, схождения и кастера на мониторе развального стенда. Передняя ось, Шкода Октавия A5 2011 года. Несмотря на «макферсон», развал можно регулировать смещением подрамника. Конкретно в этом случае кастер останется красным Резьба на рулевых тягах и наконечниках позволяет регулировать схождение колес Похожий лист должны выдать, когда все настроят. В нем параметры, с которыми машина заехала на стенд, и результат работы. В этом случае развал-схождение делали на Киа Соул. Сзади балка, поэтому показания до и после примерно одинаковые

Передняя ось, Шкода Октавия A5 2011 года. Несмотря на «макферсон», развал можно регулировать смещением подрамника. Конкретно в этом случае кастер останется красным Резьба на рулевых тягах и наконечниках позволяет регулировать схождение колес Похожий лист должны выдать, когда все настроят. В нем параметры, с которыми машина заехала на стенд, и результат работы. В этом случае развал-схождение делали на Киа Соул. Сзади балка, поэтому показания до и после примерно одинаковыеКак понять, что нужно делать развал-схождение

Автомобиль при движении уводит вправо или влево. Причин может быть несколько — от уклона дороги и спущенного колеса до необходимости замены рулевых тяг или ступичного подшипника. Но чаще всего именно регулировка схождения-развала помогает вернуть правильную траекторию движения автомобиля. Проверить это легко: на загородной трассе, где мало машин, на ровном и прямом участке дороги отпустить руль и проследить за поведением автомобиля. Он должен ехать по прямой без уводов в сторону, виляний и подруливаний.

Колеса стоят прямо, руль — нет. Иногда положение руля немного смещается влево или вправо относительно центра — обычно после ремонта подвески или из-за резкого удара колесом.

Резина на колесе изнашивается неравномерно. Например, внутренняя часть колеса стерта сильнее, чем внешняя. Такое случается при отрицательном развале и схождении. При положительном изнашивается внешняя часть колеса. Чтобы не выбрасывать такую резину, в качестве оперативной меры допустимо поменять покрышки местами так, чтобы износ шел на сохранившуюся часть протектора. Но лучше отрегулировать углы установки колес и избавиться от этой проблемы.

/guide/rezina/

Как подобрать резину для легкового автомобиля или кроссовера

Из-за проблем с развалом-схождением внутренняя часть шины стерлась до кордаКак часто нужно делать развал-схождение

Сезонно. В идеале развал-схождение нужно делать при сезонной смене шин. Особенно если на разные сезоны у вас колеса с разными параметрами. Например, на лето — 19 дюймов с низкопрофильной резиной, на зиму — 17 дюймов с обычной.

Особенно если на разные сезоны у вас колеса с разными параметрами. Например, на лето — 19 дюймов с низкопрофильной резиной, на зиму — 17 дюймов с обычной.

По пробегу. Сход-развал рекомендуют делать каждые 20 000 км. Естественный износ деталей подвески может привести к изменениям углов установки колес.

По необходимости. Если автомобиль попал на скорости в яму, настройки тоже могут сбиться. Когда после этого машину начинает уводить в сторону, резина изнашивается неравномерно, изменилось положение руля — необходимо делать схождение-развал.

/serious-damage-stories/

«Повезло еще, что не встали на трассе»: 10 историй о серьезных поломках автомобиля

После ремонта ходовой. Там одни компоненты влияют на углы установки колес, другие — нет, но делать развал нередко приходится в любом случае. Вот пример: стойки стабилизатора не должны ни на что повлиять, но есть машины, на которых для этого приходится снимать подрамник, — а значит, придется делать развал-схождение.

Также важно помнить, что неоригинальные детали могут отличаться от оригинальных по геометрии. Из-за них могут серьезно сбиться настройки, которые не отрегулировать.

Можно ли отрегулировать развал-схождение самому

Теоретически — можно попытаться. Но все же рекомендую обратиться в сервис, где есть необходимое оборудование. Электронные измерения очень точные, в них параметры отслеживаются до долей градуса — минут. При самостоятельном измерении погрешность может быть большой. Кроме того, перед этим необходимо узнать заводские параметры подвески.

Обычно в гаражных условиях для настройки углов натягивают нить по длине машины параллельно колесам. Далее выставляют колеса ровно и измеряют расстояние от диска до нити в двух точках, если оно разное, это колесо нужно отрегулировать.

8 узлов и жидкостей в авто, которые стоит контролировать после окончания гарантии

Еще один, дедовский, способ регулировки схождения-развала — приставить к диску уровень и посмотреть, насколько отклоняется пузырек воздуха в жидкости. Такая настройка тоже приблизительна и допустима только в том случае, если нет возможности обратиться в профессиональный сервис.

Такая настройка тоже приблизительна и допустима только в том случае, если нет возможности обратиться в профессиональный сервис.

Как выбрать СТО

Диагностика подвески — первое, что предложат на хорошей СТО. Если в ходовой части автомобиля есть какие-то люфты, которых не должно быть, то схождение-развал делать бессмысленно.

Калибровка стенда. Для точной диагностики и настройки стенд для развала-схождения должен быть откалиброван. Спросите в автосервисе, когда последний раз делали калибровку стенда, есть ли подтверждающие документы. Такую калибровку надо проводить регулярно, но некоторые СТО на этом экономят. Совсем здорово, когда у СТО есть свое оборудование для калибровки.

Опытный мастер. Хороший результат зависит от мастера. Недостаточно ввести в программу название марки и модели автомобиля, на точность настройки может влиять даже год выпуска и маркировка кузова. Неопытные настройщики могут это не учесть.

Хороший мастер спросит, когда ремонтировали подвеску, какие запчасти использовали, проверит состояние резины и расспросит о поведении машины на дороге. Также он убедится, что руль стоит ровно.

Также он убедится, что руль стоит ровно.

/guide/detailing-in-details/

Автомобильный детейлинг: что это такое, какая от него польза

Если на автомобиле установили нештатные колеса или тюнинговали подвеску, то стандартные нормативы углов для этой модели уже не подходят. Поэтому схождение-развал для таких авто должен делать мастер с большим опытом, который не будет ориентироваться только по зеленым зонам на мониторе развального стенда.

Бывает, что хороший специалист сможет выставить углы в тех случаях, когда другие мастера пасуют, — просто потому, что знает особенности конкретной марки или модели. Например, посоветует купить особенные болты взамен тех, что поставили при ремонте подвески просто на глаз.

Документы и гарантия. Хорошие автосервисы дают гарантию на свою работу и предоставляют клиенту не только кассовый чек, но и распечатку параметров углов колес до и после регулировки. Это нужно прежде всего мастеру: когда автомобиль в следующий раз заедет на стенд, он уже будет знать предысторию.

Стоимость услуг по регулировке углов колес зависит от уровня оснащенности СТО и региона, в котором расположен сервис. Ориентировочно это 1500—3500 Р.

Запомнить

- Если на автомобиле стоят нештатные колеса или тюнинговали подвеску, то стандартные нормативы углов установки колес для этой модели не подходят.

- Во многих случаях нельзя настроить какой-то угол установки. Иногда это все углы сразу.

- Записывайтесь на развал-схождение, если авто при движении уводит в сторону, неравномерно стираются шины или колеса стоят прямо, а руль криво.

- Иногда эти признаки вызваны другими причинами: разным давлением шин на одной оси, неправильной установкой руля или изношенной подвеской.

- Проверяйте углы установки колес каждые 20 000 км пробега, при попадании в глубокие ямы, после ремонта подвески и при сезонной смене колес, если у комплектов разные параметры.

- Заказывайте развал-схождение в сервисе: даже если дело будет только в резине, экономить не получится.

Регулировка развала схождения. Сход развал своими руками. Советы и рекомендации как самому сделать развал схождение колес

Ни для кого не станет новостью, что неверно налаженный сход развала колеса, может привести не только к ухудшению качества покрышки, но и к большому расходу топлива. Именно поэтому, к выставлению схода развала стоит подойти ответственно.

Своими силами настроить сход развал совсем не сложно, как может показаться сначала. Мы попытаемся рассмотреть этот вопрос подробно и дать оптимальные советы новичкам механикам. Стабилизация пары управляющих колес – это тот самый важный аспект, который влияет на устойчивость машины на дороге. Что это значит? Колеса должны двигаться по прямой линии, а минуя поворот возвращаться в исходное положение.

Следуя из этого, острая необходимость процедуры стабилизации колес разъясняется очень просто. Когда автомобиль двигается, колеса, которые не стабилизированы, уходят в сторону в результате толчков от дороги. Тогда водитель должен возвращать колеса в нужное (прямолинейное) положение. Учитывая то, что это происходит постоянно, человек за рулем сильнее устает. К тому же, контакты рулевого привода быстрее износятся. А с увеличением скорости, растущая неустойчивость становиться не безопасной.

Тогда водитель должен возвращать колеса в нужное (прямолинейное) положение. Учитывая то, что это происходит постоянно, человек за рулем сильнее устает. К тому же, контакты рулевого привода быстрее износятся. А с увеличением скорости, растущая неустойчивость становиться не безопасной.

От чего зависит стабилизация управляемых колес? Ответ простой: от их схождения или развала. Регулировка схода развала колес может быть произведена в автомастерских, но вполне возможно решить эту проблему и своими руками.

Признаки что нужно регулировать сход развал

Первое, что необходимо сделать, это определить необходимость регулировки схода развала.

Рассмотрим это по пунктам:

- Непрерывный уход авто от заданного курса прямолинейного движения в ту или иную сторону.

- Неоднородная изношенность покрышек.

- При осмотре желобка протектора переднего колеса вдоль оси вращения, необходимо осмотреть края этого желобка. Кромки одинаковые – это значит, что нет причин для беспокойства, если же одна из них имеет некоторую заостренность, а другая – нет, значит у вас есть проблема.

Но на это стоит обращать внимание лишь при спокойной езде. Если же вы являетесь поклонником быстрой скорости, то это условие может быть обманчивым.

Но на это стоит обращать внимание лишь при спокойной езде. Если же вы являетесь поклонником быстрой скорости, то это условие может быть обманчивым. - Трудность управления при маневрах.

Наличие хотя бы одно из таких симптомов говорит, что нужно устанавливать развал схождения. Водители имеющие некоторый опыт в ремонте авто своими руками при большом желании могут выполнять сход развал самостоятельно.

Как регулируется сход развал?

Для ремонта вам будут необходимы:

- линейка;

- мел;

- стандартный набор инструментов;

- шнур с отвесом;

- ровная площадка с ямой или подъемником.

Сначала потребуется выяснить: насколько точно было произведено схождение раньше. Т.е. «нулевое» ли положение у рулевой рейки при прямолинейном движении. Как это сделать? Следуем дальнейшим указаниям:

- Поставить автомобиль на ровной поверхности.

- Затем повернуть максимально руль в одну сторону, сделав метку сверху на руле (посередине круга) повернуть руль до упора в другую сторону.

При этом необходимо посчитать количество целых оборотов и частей целой окружности (долей).

При этом необходимо посчитать количество целых оборотов и частей целой окружности (долей). - Когда посчитали поделить полученное количество на 2 и повернуть руль в это положение.

Если данный результат совпадает с привычным положением руля, то «нулевое» положение рейки выставлено. Если нет, это придется сделать самим.

Как выставить «нулевое» положение?

Необходимо снять руль, для этого отвинтите гайку. После зафиксировать его в посчитанном нами «нулевом» положении (спицы руля должны располагаться симметрично). Теперь мы будем ориентироваться по этому положению. Дабы себя проверить, нужно поочередно вращать руль влево/право — в обе стороны он должен поворачиваться на одинаковое количество оборотов, по этому поворачивая колесо до предела в стороны, подсчитывайте их.

Далее нужно ослабить стопорные гайки наконечников рулевых тяг. Одну тягу следует немного выкрутить, а вторую закрутить на такое же самое количество оборотов (это очень важно!). Такую процедуру можно сделать один раз и более не менять положение руля. А в дальнейшем – лишь регулировать схождения.

А в дальнейшем – лишь регулировать схождения.

Как отрегулировать схождения колес?

После проверки прямолинейности нужно проверить степень загруженности транспорта, давления в покрышках, надежно ли крепление подвески и механизма руля на предмет наличия стука при повороте руля. После этого уже можно приступить непосредственно к проверке и настройке схождения.

Для определения уровня схождения колес, следует вычислить разницу между точками на ободе спереди и сзади его оси геометрии. Для этого нужно использовать специальную цепь с линейкой или натяжной прибор.

Чтоб измерить схождение линейка устанавливается меж колес, таким образом, чтоб наконечники труб уперлись в бок покрышек, а цепочки дотрагивались до земли. Когда вы установите стрелку на нулевое положение, машину следует немного перекатить вперед, чтобы линейка очутилась сзади оси колес. При этом стрелка должна показывать уровень схождения. В случае несовпадения с нормой она должна быть откорректирована.

Для того, чтобы отрегулировать схождение колес нужно вращать соединительные муфты боковых рулевых тяг. Когда эта операция проведена, контрольные гайки необходимо надежно затянуть.

Регулировка угла развала колес

Самым сложным процессом выступает проверка и регулировка развала колес, но и ее возможно выполнить своими силами. Чтоб это сделать машина поднимается так, чтоб колеса не дотрагивались до земли. После этого нужно вычислить места одинакового биения на боковых частях шин. Выставив колеса в положение движения по прямой, рядом с колесом следует подвесить груз. Мелом делаются метки по окружности колеса сверху и снизу. С помощью шнура с отвесом вычислите дистанцию от обода до шнура.

Разница дистанций между нитью груза и верхней частью обода и есть уровень развала.Для точности выполнения процедуры прокатите машину, чтоб колесо повернулось на 90?.. Повторить несколько раз и записать результаты.

Далее снимаем колесо автомобиля и отпускаем 2 болта крепления кронштейна стойки амортизатора к поворотному кулаку. Затем сдвигаем вовнутрь или наружу поворотный кулак, в каком направлении, и на какое расстояние, зависит от результатов ваших замеров. Именно таким образом вы сможете установить необходимый угол развала. После процедуры нужно подтянуть болты, поставить колесо и вновь провести замеры.

Затем сдвигаем вовнутрь или наружу поворотный кулак, в каком направлении, и на какое расстояние, зависит от результатов ваших замеров. Именно таким образом вы сможете установить необходимый угол развала. После процедуры нужно подтянуть болты, поставить колесо и вновь провести замеры.

Помните, что на автомобилях с задним приводом допускают норму угла развала передних колес, где-то в пределах +1 — +3 мм, а у машин с передним приводом такая норма равна от -1 до +1 мм.

После завершения всей процедуры, не забывайте проверять затяжку всех тех болтов, которыми вы проводили регулировку. А в после завершения регулировки развала схождения проверьте выравнивание автомобиля на дороге.

Делая сход-развал собственноручно, помните, что необходимо проводить замеры несколько раз (не меньше трех), после чего взять среднеарифметическое значение. Если развал-схождение отрегулированы правильно, транспортное средство не будет уходить в сторону при движении, а износ протектора шин будет равномерный.

Вся процедура регулировки проводится заново в том случае, если после проведенных работ машина всё равно «уходит» с траектории прямолинейного движения. О неправильном развале или схождении также скажет неравномерный износ покрышек, по этому диагностика шин также будет не лишней.

Самостоятельное выполнение такой нелегкой процедуры сэкономить приличную сумму денег, однако помните, что для большинства современных автомобилей рекомендуется проведение сход/развал в автосервисах. Дополнительно вы можете посмотреть обучающее видео, как самому сделать развал схождение тут.

Три расхожих заблуждения о развал-схождении колес — Лайфхак

- Лайфхак

- Эксплуатация

Фото www.multiscreensite.com

Даже те автовладельцы, кто по жизни с техникой только на «вы», вынуждены иметь хотя бы отдаленное представление о характере профилактических работ, которые периодически требуется проводить с машиной. Ведь речь идет не только о здоровье «железного коня», но и о безопасности самого водителя и его пассажиров. Например, о такой важной процедуре, как регулировка углов развал-схождения колес, среди автомобилистов ходит много разных мифов, самые распространенные из которых развенчал портал «АвтоВзгляд».

Например, о такой важной процедуре, как регулировка углов развал-схождения колес, среди автомобилистов ходит много разных мифов, самые распространенные из которых развенчал портал «АвтоВзгляд».

Иван Флягин

Все четыре колеса на автомобиле должны быть установлены под определенным углом. Если мы посмотрим на машину спереди или сзади и увидим, что колеса расположены не строго параллельно друг-другу, а под значительным углом, то у них не отрегулирован развал. А если посмотреть на машину сверху и заметить аналогичную неровность, то очевидно, что у колес нарушено схождение.

Правильная настройка углов установки колес, что в обиходе и называется «развал-схождением», обеспечивает при движении автомобиля оптимальный контакт шины с поверхностью дороги. От этого зависит не только преждевременный износ «резины», но самое главное — устойчивость машины и ее управляемость, а следовательно — безопасность дорожного движения.

Миф 1: раз в сезон

Не верьте официальным сайтам автосревисов, которые рекомендуют регулировать развал-схождение строго раз в сезон. Чем чаще к ним будут обращаться клиенты, тем им выгодней. Но это имеет смысл только в одном случае — когда у летних и зимних колес разный размер. Например, если летом ваш автомобиль обут в низкопрофильные 19-дюймовые шины, а зимой — в практичные 17-дюймовые, вам действительно придется тратиться на развал-схождение раз в межсезонье. А при одинаковых размерах сезонных покрышек регулировать углы необязательно.

Чем чаще к ним будут обращаться клиенты, тем им выгодней. Но это имеет смысл только в одном случае — когда у летних и зимних колес разный размер. Например, если летом ваш автомобиль обут в низкопрофильные 19-дюймовые шины, а зимой — в практичные 17-дюймовые, вам действительно придется тратиться на развал-схождение раз в межсезонье. А при одинаковых размерах сезонных покрышек регулировать углы необязательно.

Миф 2: самостоятельная настройка

Многим приходилось слышать байки, как водители старшего поколения в советские времена умудрялись своими силами настраивать углы установки колес у своих «ласточек». Но речь в таких случаях идет о «Жигулях» или старинных иномарках с простой подвеской.

Самостоятельно сделать развал-схождение в современных машинах где-нибудь в гараже у подавляющего большинства автовладельцев не получится. Для этого требуется специальное оборудование и умение им пользоваться, поэтому лучше не экономить на такой процедуре и не отдавать машину всякого рода гаражным мастерам. К тому же не стоит забывать, что перед регулировкой рекомендуется пройти полноценную диагностику подвески.

К тому же не стоит забывать, что перед регулировкой рекомендуется пройти полноценную диагностику подвески.

Миф 3: идеальная настройка — 0 градусов

Как уверяют эксперты, «нулевой» угол развала обеспечивает максимальное пятно контакта колеса с дорогой только в положении руль прямо. То есть в этом случае на прямой траектории машина управляется оптимально. Однако при повороте колесо наклоняется на несколько градусов, пятно контакта уменьшается, и складывается противоположный эффект: машина уже менее устойчива и хуже тормозит. Так что идеальные углы колес на «легковушках» действительно близки к нулю, но редко, когда совпадают с этим параметром.

142886

Для каждой конкретной модели размеры рассчитываются отдельно в зависимости от ее массы, габаритов, технических характеристик двигателя, подвески, тормозной системы, предполагаемых режимов эксплуатации автомобиля и многого другого.

В программное обеспечение специального компьютерного оборудования для регулировки развала-схождения заложены заводские параметры определенных моделей, и мастеру остается выбрать нужные настройки.

Когда необходима регулировка

Самым распространенным признаком неотрегулированного развал-схождения считаются неравномерно стертые шины с наружной или внутренней стороны. Обычно это сопровождается следующим явлением: во время движения по ровной дороге машина «рыскает» или ее тянет в сторону, несмотря на то, что руль удерживается в прямом положении. В случае торможения автомобиль также заметно уводит в бок или даже заносит. Иногда при поворотах руль тяжелеет и требует дополнительного усилия. Все это можно считать явными сигналами для необходимости проверить у специалистов настройки угла колес.

Кроме того, регулировка развал-схождения требуется после замены рулевых тяг или наконечников, стоек стабилизатора, рычагов, ступичных или опорных подшипников, шаровых опор или после любого другого ремонта ходовой части, затрагивающего эти узлы.

- Автомобили

- Прайс-лист

Выбираем доступную премиальную машину для VIP-персоны на вторичке

20995

- Автомобили

- Прайс-лист

Выбираем доступную премиальную машину для VIP-персоны на вторичке

20995

Подпишитесь на канал «Автовзгляд»:

- Telegram

- Яндекс.

Дзен

Дзен

безопасность дорожного движения, колеса, автосервис, технология, ремонт, техническое обслуживание

Сход/развал передняя ось — Статьи

Сход/развал передняя ось представляет собой регулирование угла положения передних колёс относительно вертикальной плоскости. Нарушение развала провоцирует снижение управляемости авто и увеличению износа шин. Техническим регламентом предусмотрено проведение регулировки схода/развала колёс при любом вмешательстве в подвеску транспортного средства.

Что представляет собой развал/схождение

Конструкция подвески гражданского легкового автомобиля представляет собой набор тщательно сбалансированных между собой узлов и деталей. Немалую важность при этом имеет геометрическое положение передних колёс, ввиду осуществления ими функций управления движением автомобиля. Одно из распространённых понятий в среде автомехаников — регулировка развала и схождения передних колёс, заключающееся в выставлении оптимального угла положения колеса относительно вертикальной оси.

Существуют 2 основных типа регулировки: это угол развала (camber) и схождения (toe) колеса.

Развал передних колёс

Этот показатель представляет собой значение угла продольной оси колеса. При отрицательном развале происходит заваливание колеса внутрь, при положительном — наружу. Но в идеале колёса должны стоять практически перпендикулярно поверхности. Развал колёс автомобиля важен по многим причинам:

неправильная регулировка создаёт излишнее давление на ступичный подшипник, что приводит к быстрому выходу его из строя; при неправильном развале колёс движущийся по неровному покрытию автомобиль теряет управляемость, поскольку пятно контакта шины с дорогой становится нестабильным. Но это во многом зависит от конфигурации подвески авто.

В случае с распространённой среди большинства легковых автомобилей подвеской МакФерсон показатель развала может приобретать небольшие отрицательные значения. Характерный пример этому — расположение колёс гоночных автомобилей, в верхней части сильно заваленных внутрь. Сделано это с целью обеспечения максимальной управляемости: при вхождении в поворот возникает крен подвески, приводящий к изменению значения развала колёс в сторону положительного. Это приводит к снижению пятна контакта, и при входе в поворот на высокой скорости провоцирует вхождение в неуправляемый занос. Изначально отрицательный развал в случае крена изменяется на нулевой, что позволяет сохранить управление над авто. Но при этом наблюдается сильный износ резины при движении по прямой.

Характерный пример этому — расположение колёс гоночных автомобилей, в верхней части сильно заваленных внутрь. Сделано это с целью обеспечения максимальной управляемости: при вхождении в поворот возникает крен подвески, приводящий к изменению значения развала колёс в сторону положительного. Это приводит к снижению пятна контакта, и при входе в поворот на высокой скорости провоцирует вхождение в неуправляемый занос. Изначально отрицательный развал в случае крена изменяется на нулевой, что позволяет сохранить управление над авто. Но при этом наблюдается сильный износ резины при движении по прямой.

Для каждой конфигурации подвески регулировка развала колёс осуществляется в особом порядке. В случае с популярной МакФерсон регулировка осуществляется путём смещения стойки амортизатора — с этой целью отверстие для крепления эксцентрикового болта в нижней части стойки имеет овальную форму. Но стоит отметить, что ряд современных автомобилей выпускается без возможности регулировки развала. В этом случае отклонение его от установленных производителем норм может означать износ сайлентблоков, резиновых втулок подвески либо деформацию кузова, вызванную ДТП.

Схождение передних колёс

Как и развал, схождение может быть положительным или отрицательным. Под схождением понимается параллельное размещение колёс относительно оси движения авто. При положительном схождении их передние кромки немного «смотрят» друг на друга, при отрицательном — разведены по сторонам.

Схождение является одним из наиболее важных параметров подвески авто, от которого напрямую зависит управляемость транспортным средством.

Стоит отметить, что при неправильном схождении передних колёс значительно сокращается срок службы сайлентблоков.

Ранее в среде автолюбителей бытовало ошибочное мнение, что схождение было разработано инженерами для компенсации развала колёс. Однако фактически эти параметры существенно разнятся между собой и единственный фактор, объединяющий их вместе — необходимость регулировки после проведения ремонта подвески.

Как показала практика, при отрицательном схождении чувствительность рулевого управление несколько возрастает, но устойчивость транспортного средства при этом снижается. Положительные значения схождения колёс делают автомобиль более устойчивым на дороге, особенно это заметно при движении по неровным покрытиям. Но при высоких значениях наблюдается повышенный износ резины.

Положительные значения схождения колёс делают автомобиль более устойчивым на дороге, особенно это заметно при движении по неровным покрытиям. Но при высоких значениях наблюдается повышенный износ резины.

Когда нужна регулировка развала/схождения

Необходимость регулировки угла положения передних колёс возникает в следующих случаях: 1. При вмешательстве в узлы и детали подвески с целью их ремонта или замены. В эту категорию входят работы по замене амортизаторов, шаровых шарниров, рулевых наконечников, тяг, рейки, сайлентблоков, рычагов в сборе и пр. 2. В случае участия машины в ДТП либо наезда на высокой скорости на лежачий полицейский, бордюр, попадание колеса в глубокую яму. 3. Специалисты автосервисов также рекомендуют проводить замер и корректировку развала/схождения при сезонной смене резины.

Движение на машине с неправильно выставленными значениями угла колёс чревато следующими последствиями:

потерей устойчивости транспорта на дороге;

снижением чувствительности и чёткости управления;

«уводом» транспортного средства в сторону при торможении или отпускании руля;

быстрым выходом из строя сайлентблоков и втулок подвески;

увеличенным износом резины.

Важно знать, что регулировка параметров для передней и задней оси автотранспортного средства должна выполняться на специализированном стенде. Любые попытки провести регулировку «на глаз» с использованием подручных методов обычно приводят к ещё большему отклонению от нормы. Следует помнить, что изменение параметров всего на 0,5 градуса уже является сильным нарушением, отрицательно влияющим на управляемость автомобиля.

Как подготовиться к развалу/схождению

Стоит отметить, что существует ряд минимальных требований, необходимых к выполнению для проведения регулировки развала и схождения передних колёс.

1. На автомобиле должны быть установлены диски с одинаковыми значениями диаметра, вылета и ширины.

2. Резины должна быть с приблизительно равным значением износа, одинакового типоразмера.

3. Давление в шинах должно соответствовать установленным значениям.

4. В подвеске должен отсутствовать люфт, вызванный неисправностью отдельных узлов. Втулки тяг, сайлентблоки, рычаги, наконечники и шаровые опоры обязаны быть полностью исправны.

Втулки тяг, сайлентблоки, рычаги, наконечники и шаровые опоры обязаны быть полностью исправны.

Внимание! Если после регулировки развала схождения наблюдается увод машины в сторону, то необходимо поменять передние колёса местами — обычно подобное поведение автомобиля связано с неравномерным износом колёс, возникшим вследствие эксплуатации авто с неотрегулированной подвеской.

Во время регулировки развала/схождения рулевое колесо устанавливается в центральное положение. Если с течением времени при движении автомобиля по прямой наблюдается отклонение руля, то необходимо повторно провести регулировку развала.

Сервис Uremont.com поможет найти автомастерскую, осуществляющую все виды работ по ремонту и настройке подвески — вам нужно просто оставить заявку на сайте. Ремонт авто с нами — недорого, быстро и удобно.

Как работает Uremont?

01

Создаете заявку

с кратким описанием работ и желаемой датой ремонта. Потратите не более 3 минут

02

Получаете предложения

от специализированных автосервисов в личном кабинете

03

Сравниваете ответы

наиболее подходящие по стоимости, отзывам, местоположению и другим параметрам

04

Подтверждаете запись

а также все условия ремонта и можно смело ехать в автосервис

Создание заявки абсолютно бесплатно и займет у вас не более 5 минут

Создать заявку

Как проверить и отрегулировать развал? Схождение и развал колес что за развал колес колеса

Процедура регулировки развала схождения колес известна сегодня и людям далеким от автомобильного мира. Тем не менее, не все понимают, чем вызвано схождение, в чем его важность и когда необходимо проверить и отрегулировать развал схождения колес. Об этом мы поговорим в этой статье.

Тем не менее, не все понимают, чем вызвано схождение, в чем его важность и когда необходимо проверить и отрегулировать развал схождения колес. Об этом мы поговорим в этой статье.

Развал и схождение колес (или как его еще называют биговка колес), это углы их установки, и значения этих углов будут разными для различных моделей автомобиля. Развалом колеса называют угол наклона колеса по отношению к дорожному полотну. При наклоне наружу говорят о положительном схлопывании, при наклоне внутрь — обрушении называют отрицательным. Чрезмерно положительный или отрицательный развал приводит к быстрому износу резины, однако в автоспорте используется отрицательный развал — он позволяет увеличить остроту реакции на руль, а для внедорожников иногда используют положительный угол развала.

Развал-схождение — это разница между расстояниями между передней и задней точками передних колес. Другими словами, это горизонтальный угол их установки. Схождение положительное, если расстояние между передними точками колесных дисков меньше, чем между задними, если же это расстояние больше, говорят об отрицательном схождении колес. Также имеется угол продольного наклона шкворня или колеса. Его неравномерные значения могут привести к затруднениям в движении за рулем и общему снижению устава автомобиля в поворотах. Ну и еще один важный теоретический момент, это то, что развал схождения, как собственно и кастер, устанавливается только на передние колеса автомобиля.

Также имеется угол продольного наклона шкворня или колеса. Его неравномерные значения могут привести к затруднениям в движении за рулем и общему снижению устава автомобиля в поворотах. Ну и еще один важный теоретический момент, это то, что развал схождения, как собственно и кастер, устанавливается только на передние колеса автомобиля.

Когда и для чего нужно производить развал

Регулировка развала схождения проводится в условиях нашей действительности примерно каждые 15 — 20 тыс. пробега для отечественных автомобилей, и каждые 30 35 тыс. пробега для иностранных машины. Но, это, так сказать, плановая проверка, а между тем, в некоторых случаях проверка и корректировка схода на развал и до установленного срока. Среди таких случаев можно отметить следующие:

- яма на дороге или другой сильный удар по ходовой части и подвеске;

- ремонт или замена шаровых опор, сайлентблоков, рычагов и тд;

- ремонт рулевой рейки или замена рулевых наконечников

- высокая степень износа шин;

- проблемы с управляемостью автомобиля или его удержанием на прямой траектории движения;

- необоснованно быстрый износ шин;

- изменение дорожного просвета автомобиля;

Что дает правильная установка схода развала и кастора?

- увеличенный срок службы шин;

- высокая степень управляемости машины в поворотах и разворотах;

- стабильное поведение автомобиля на дороге;

- повышенная отзывчивость автомобиля на команды руля;

- небольшое снижение расхода топлива;

Важность правильной установки развала схождения колес можно выразить двумя словами — безопасность и экономия. Поэтому пренебрегать этой процедурой ни в коем случае не стоит.

Поэтому пренебрегать этой процедурой ни в коем случае не стоит.

Как сделать сход-развал

Сегодня проверка и регулировка Сборка развала производится на СТО, оборудованных специальными стендами. Наиболее распространены сейчас оптические и компьютерные стенды для регулировки развала-схождения. Споры о том, где лучше производить такую регулировку, не первый год не субсидируются. Скажем, все зависит от уровня мастерства и добросовестности специалиста, выполняющего эту процедуру. Неоспоримым преимуществом компьютерных стендов является регистрация положения задних колес в процессе регулировки развала-схождения. Однако на оптических стендах можно выставить практически идеальные углы поворотов колес. Но перед регулировкой развала схождения следует убедиться, что передние шины отбалансированы и ходовая работает исправно. Иначе регулировать развал схождения нет смысла. После ремонта или замены необходимых узлов процедуру придется повторить еще раз. И должного эффекта такая регулировка при наличии проблем с ходовой или подвеской не даст. Если вы не уверены, является ли причиной возникших проблем поломка развала схождения, или причина в чем-то другом, то пройдите проверку, конечно же стоит.

Если вы не уверены, является ли причиной возникших проблем поломка развала схождения, или причина в чем-то другом, то пройдите проверку, конечно же стоит.

Помимо вышеописанной процедуры проверки, сбор развала, проводимый опытным специалистом, позволяет определить, побывал ли автомобиль в дорожно-транспортном происшествии. Ибо, нарушение взаимного расположения лонжеронов, искривление геометрии кузова и прочие последствия ударов, на первый взгляд очень незаметны. Однако не отразиться на углах колес они не могут.

В случае, если вы во время езды зацепили достаточно глубокую дыру или замшевый диск каким-либо другим способом, перед проверкой развала схождения поврежденный диск следует либо исправить на специальном станке, либо заменить. Кроме того, давление в шинах проверяется перед процедурой проверки и регулировки. Разница этого давления может нивелировать всю работу и даже привести к обострению возникающих проблем. Кроме того, знающие люди советуют раз в десять тысяч километров пробега менять передние и задние колеса. Эта простая процедура позволяет обеспечить равномерный износ автомобильных шин. Дело в том, что резина на передних колесах всегда прошивается быстрее, чем на задних.

Эта простая процедура позволяет обеспечить равномерный износ автомобильных шин. Дело в том, что резина на передних колесах всегда прошивается быстрее, чем на задних.

Многое, точность и оперативность регулировки развала концентрации, будет зависеть от калибровки стенда, на котором эта процедура производится. Но это, как уже было сказано, относится к добросовестности специалиста, осуществляющего проверку. Работоспособность инструмента, это в первую очередь забота мастера.

Видео про развал фото

выводы

Проверка и регулировка развала схождения колес, процедура важная и нужная. Особенно это важно в наших условиях, с нашими дорогами и их состоянием. Ввод правильных поворотов Сбор колесного развала позволяет повысить управляемость автомобиля, его устойчивость и устойчивость при движении. Также за счет правильных значений углов установки колес снижается износ ходов авто и расход топлива.

Словосочетание «разваливается» приходилось слышать практически каждому, сегодня оно известно даже тем, кто не водит машину. Но не все знают значение этого термина, когда и как делать расклад, степень его важности и необходимость проведения.

Но не все знают значение этого термина, когда и как делать расклад, степень его важности и необходимость проведения.

Что такое коллапс?

Развал-схождение — два важных параметра настройки подвески, от правильности настройки которых напрямую зависит контроллер автомобиля. При идеальной регулировке колесные системы находятся в правильном положении при любой скорости движения и при разных углах поворота. Автомобиль отлично ведет себя на дороге, протекторы изнашиваются равномерно, топливо расходуется в стандартном режиме.

Что нужно для работы?

Развал — это угол наклона колес относительно дороги: при верхней части колеса развал считается отрицательным, если он наклонен наружу — положительным. При нулевом смятии износ шин сводится к минимуму, что способствует продлению их эксплуатации.

Схождение — это угол между направлением движения автомобиля и продольной плоскостью вращения дисков. В большинстве случаев колеса автомобиля наклонены немного вперед, в этом случае следует говорить о положительном способе, в противном случае об отрицательном.

Что такое крах расклада?

Регулировка сход-развала повышает устойчивость, улучшает управляемость автомобиля, уменьшает заносы ТС, способствует экономии топлива, снижает износ шин. Автомобиль становится более маневренным, он менее склонен к заносу и опрокидыванию в экстремальных ситуациях, у него хороший риск.

Почему он сбит?

Детали подвески и рулевого управления состоят из тяги и рычагов, соединенных шарнирными элементами. Износ и выход из строя деталей и соединительных элементов приводит к образованию повышенного люфта. В результате изменения расстояния между плоскостями шин управляемость машины снижается, автомобиль лежит во время движения, шины преждевременные. Неисправность может возникнуть и при выходе из строя других деталей.

Как выполнить настройку?

При необходимости ремонта лучше всего обратиться в сервисный центр за профессиональной помощью. Автомобиль должен стоять на ровной поверхности, настройка состоит из двух процедур: регулировки развала и схождения. Технология проведения в разных сервисах может отличаться, иногда мастер предварительно проверяет давление в шинах, данные с установленных на шины шин заносятся в компьютер, результаты заносятся в таблицу. Измерения проводятся с нагрузкой на ствол и без нее, после получения результатов проводится регулировка.

Технология проведения в разных сервисах может отличаться, иногда мастер предварительно проверяет давление в шинах, данные с установленных на шины шин заносятся в компьютер, результаты заносятся в таблицу. Измерения проводятся с нагрузкой на ствол и без нее, после получения результатов проводится регулировка.

Необходимость

Перед разборкой следует провести небольшую проверку. Если вы поворачиваете руль в любую сторону, а ТС продолжает двигаться по прямой, необходимо немедленно обратиться в сервисный центр. Ремонт необходим и в том случае, если при центральном положении руля автомобиль не движется в плавном направлении. Одним из важных признаков нарушения сход-развала является неравномерный износ шин.

Проверка сбора

Каждый раз при езде на сотке при малейших подозрениях на нарушения опущено, перед тем как делать развал мастера, рекомендуется проверить его самостоятельно. Неточности в работе сход-развала заметны визуально, их можно распознать по определенным отклонениям в поведении автомобиля. Первым признаком является уход автомобиля в сторону с равномерным контролем и без усилий, а также быстрое истирание шин, неравномерный износ протектора.

Первым признаком является уход автомобиля в сторону с равномерным контролем и без усилий, а также быстрое истирание шин, неравномерный износ протектора.

Как часто делать развал-схождение?

Процедуру рекомендуется проводить через 15-20 тыс. км, примерно раз в полгода. В целях экономии корректировку балла следует проводить после каждой смены шин весной и осенью. Регулировку также следует производить в следующих случаях:

- проведение некоторых видов ремонтных работ, замена расходных материалов;

- нарушение нормальной эксплуатации автомобиля (увод в сторону, смещение руля, задержки в управлении, «плавание» в колее;

- разный радиус поворота вправо/влево, невозврат автомобиля при выходе из поворота.

Что будет, если не делать?

Если развал-схождение делать редко или не делать, транспортабельность автомобиля снижается. Автомобиль может быть неплох в самый неожиданный момент, при движении по сухому покрытию проблем может и не быть, а при попадании на мокрый или обледенелый участок машина может уйти не в ту сторону. Непрерывная езда с нерегулируемым сходом может спровоцировать «необдуманную» подвеску машины, в результате снизится ее устойчивость. Транспортное средство может быть фактором высокого риска для остальной части движения.

Непрерывная езда с нерегулируемым сходом может спровоцировать «необдуманную» подвеску машины, в результате снизится ее устойчивость. Транспортное средство может быть фактором высокого риска для остальной части движения.

Развал автомобиля схождение на фото

Регулировка развала схождения колес своими руками

Углы установки автомобильных колес, известные в быту как развал-схождение, влияют на его управляемость, устойчивость на поворотах и износ шин.

Развал — это угол между вертикалью и плоскостью вращения колеса.

Развал считается отрицательным, если колеса наклонены верхней стороной внутрь, и положительным, если верхней стороной наружу.

В большинстве случаев под развалом колес автомобиля понимают статический развал управляемых колес, указанный при техническом обслуживании автомобиля.

В некоторых автомобилях регулировке подлежит статический развал неуправляемых колес.

Основное назначение статического развала управляемых колес — уменьшить передачу на руль их движения, возникающего при выезде на мелкие неровности покрытия.

Вместо передачи через рулевые трапеции на руль они гасятся за счет эластичности шин.

Кроме того, развал обеспечивает максимальное сцепление шины с поверхностью дороги при движении автомобиля и устойчивость на поворотах, влияя, таким образом, на устойчивость и управляемость, а также влияет на интенсивность и характер износа протектора шины.

С точки зрения кинематики подвеска разваливалась, наряду с углом поперечного наклона оси поворота управляемого колеса влияет на величину радиуса рифучата, но его влияние существенно меньше второго указанного параметра.

В случае автомобиля с подвеской большинства типов, за исключением МакФерсон, развал для передних управляемых колес, как правило, имеет незначительное положительное значение (колеса наклонены наружу) — в пределах от 0′ до 45′ , местами до 2°.

Это его значение позволяет уменьшить усилия на управляемых колесах и уменьшить передачу на рулевое управление рывков, возникающих при движении по неровностям дороги.

Большой отрицательный развал («Колеса Домича») является признаком износа подвески или неправильной ее регулировки и приводит к быстрому износу шин, ухудшению сцепных свойств на ровной дороге и нарушению устойчивости автомобиля.

Однако на автомобилях с подвеской МакФерсон применяется нулевой или малый отрицательный развал, что связано с различием других установочных параметров этой подвески, обусловленным ее конструктивными особенностями.

Также отрицательный развал устанавливается на гоночные автомобили, предназначенные для езды на овальных, на внутренних колесах.

На двухтактных подвесках статический развал, как правило, можно регулировать.

На автомобилях с подвеской МакФерсон уменьшение клиренса простым укорачиванием пружин приведет к изменению всех четырех углов установки колеса, поэтому для изменения клиренса необходимо менять весь узел крепления подвески.

Первоначально статическое обрушение измерялось с помощью водопровода и уровней различных систем, либо оптических датчиков с компьютерной обработкой, либо в настоящее время используются гравитационные датчики наклона.

Стоит отметить, что на практике угол статического развала задается очень грубо (допуск при его установке обычно сопоставим с его значением) и, кроме того, он довольно сильно меняется при выполнении подвески.

Так что на практике его установка в основном влияет на равномерный износ протектора передней шины — неправильно выставленный развал приводит к повышенному износу внутренней или внешней стороны протектора шины. Кроме того, развал должен быть одинаковым с обеих сторон, так как при одностороннем наклоне колес автомобиль начинает «уводить» в сторону при движении по прямой.

На автомобиле с независимой или полунезависимой подвеской развал колеблется в больших пределах при крене автомобиля или изменении загрузки.

Значение развала, возникающего при движении автомобиля, называется динамическим развалом колес.

На большегрузных автомобилях «Татра» с подвеской на качающихся полуосях динамический развал задних колес на ненагруженном автомобиле настолько велик, что автомобиль едет, опираясь только на внешнюю часть шины.

Даже в подвеске с двойными поперечными рычагами, вполне совершенной с точки зрения кинематики, как правило, при максимальном ходе сжатия заданный изначально положительный статический развал сменяется отрицательным динамическим.

Схождение — Угол между направлением движения и плоскостью вращения колеса.

Очень часто говорят о суммарном соединении двух колес на одной оси.

В некоторых автомобилях можно регулировать схождение как передних колес, так и задних.

Назначение схождения заключается в компенсации возникающего при наличии положительного развала (динамической дестабилизации) колес, что значительно снижает износ шин. Оба уголка взаимосвязаны и регулируются исключительно в комплекте.

Выравнивание измеряется в градусах/минутах (знаки ° и ‘) и в миллиметрах.

Схождение в миллиметрах — это расстояние между задними кромками колеса минус расстояние между передними кромками колеса (в справочниках обычно приводятся данные по стандартным колесам, при произвольном диаметре колеса требуется перерасчет). Это определение верно только в случае целых, правильно установленных колес.

Это определение верно только в случае целых, правильно установленных колес.

В противном случае применяется процедура Ran-Out (RUN OUT), которая вычитает колесо колеса из величины сходимости.

Неправильно отрегулированное схождение является основной (но не единственной) причиной ускоренного износа шин.

Одним из первых признаков неправильно установленного схождения является визг шин в повороте на небольшой скорости. При 3 и более мм шина полностью стирается менее чем за 1000 км.

Иногда вместо сходящихся колес может потребоваться установка их расхождения (например, на задней оси с независимой подвеской колеса).

Кастер — Угол между вертикалью и проекцией оси вращения колеса на продольную плоскость автомобиля.

Продольный наклон обеспечивает самоуправляемость инвалидной коляски за счет скорости автомобиля.

Другими словами: машина сама выходит из поворота; Отпущенный и имеющий свободный ход руль возвращается в положение прямолинейного движения (на ровной дороге, с отрегулированными механизмами).

Это происходит, конечно, при положительном замке.

Например, воронка позволяет ездить на велосипеде, не держась за руль.

На обычных автомобилях Кастр имеет положительное значение (например, 2,35 градуса у Mitsubishi Outlander XL). Спортсмены устанавливают это значение на несколько градусов больше, что делает ход автомобиля стабильным, а также повышает стремление автомобиля к прямолинейному движению. Наоборот, на цирковых велосипедах или на погрузчиках воронка часто равна нулю, так как скорость движения сравнительно невелика, но возможен поворот по меньшему радиусу.

Но машина создана для большей скорости, поэтому требует лучшей управляемости.

Угол пересечения оси наклона колес

Этот угол обеспечивает самоуправляемость управляемых колес за счет автомобиля.

Дело в том, что в момент отклонения колеса от «нейтрали» начинает подниматься передок.

А так как весит много, то при отпускании руля под действием силы тяжести система стремится занять исходное положение, соответствующее движению по прямой.

Верно, что при этой стабилизационной работе должно сохраняться (пусть и небольшое, но нежелательное) положительное плечо качки. Изначально поперечный угол наклона оси поворота был применен инженерами для устранения недостатков подвески автомобиля.

Избавился от таких «болячек» автомобиля, как положительный развал колес и положительное плечо качения.

Во многих современных автомобилях используется подвеска типа «Мак-Ферссон».

Позволяет получить отрицательное или нулевое плечо реки.

Ведь ось вращения колеса состоит из опоры из одного единственного рычага, который легко помещается внутрь колеса. Но эта подвеска не идеальна, так как из-за ее конструкции угол наклона оси поворота практически невозможен.

В повороте он внешнее колесо наклоняет на невыгодный угол (как положительный развал), а внутреннее колесо при этом наклоняется в противоположную сторону.

В результате пятно контакта на внешнем колесе значительно уменьшается.

А так как на внешнее колесо в повороте большая нагрузка, то вся ось сильно проигрывает в сцеплении.

Это, конечно, можно частично компенсировать заклинанием и коллапсом.

Тогда сцепление внешнего колеса будет хорошим, а внутреннее (менее важное) колесо почти исчезнет.

Зачем нужен развал-схождение на машине?

Для человека этот вопрос уже давно управляется этим вопросом.

Так как кто хоть раз в жизни ездил на машине с нормально отрегулированным развалом развала, тот в дальнейшем чувствует машину на дороге и малейшие отклонения поворотов от нормы, ведь удовольствия от вождения уже нет.

Углы установки колес придуманы конструкторами для того, чтобы мы в полной мере чувствовали себя на дороге комфортно и главное — безопасно, чтобы получить ощущение полного контроля над поведением автомобиля.

Автомобиль с нормальным развалом схождения колес имеет:

1. Хорошая курсовая устойчивость (отклонения от прямолинейного движения должны быть минимальными).

2. Легкое обращение.

3. Маневренность.

4. Меньшая склонность к заносу и опрокидыванию в экстремальных ситуациях.

5. Хорошая прокатка.

6. Экономия топлива.

7. Максимальный ресурс шин на износ и тд.

Автомобиль с сильно нарушенным развалом схождения колес, наоборот, в любой момент может «подложить свинью».

Например, при езде по сухому асфальту вроде бы все хорошо, но стоит только вдруг попасть на мокрую или скользкую дорогу, и ваша машина может вдруг «захотеть» ехать туда, куда вам не захочется.

Автомобиль постоянно приходится «подбирать» (подстраивать) на дороге.

При этом становится постоянным фактором риска не только для водителя, но и для окружающих машин и пешеходов.

Вы никогда не задумывались над ставками дорожно-транспортных происшествий, в которых часто звучат фразы, типа: «Я не справился».

В большинстве случаев это следствие неправильно отрегулированной подвески автомобиля.

Совет

При покупке подержанного автомобиля перед совершением сделки рекомендуется проверить геометрию кузова, на момент ухода автомобиля в прошлое внешний вид может быть обманчив.

Машины попадаются из двух частей, перед с одной, зад с другой.

Причина увода автомобиля — неправильная регулировка углов установки колес. Поговорим, что такое коллапс и конвергенция и когда это нужно делать.

Развал-схождение

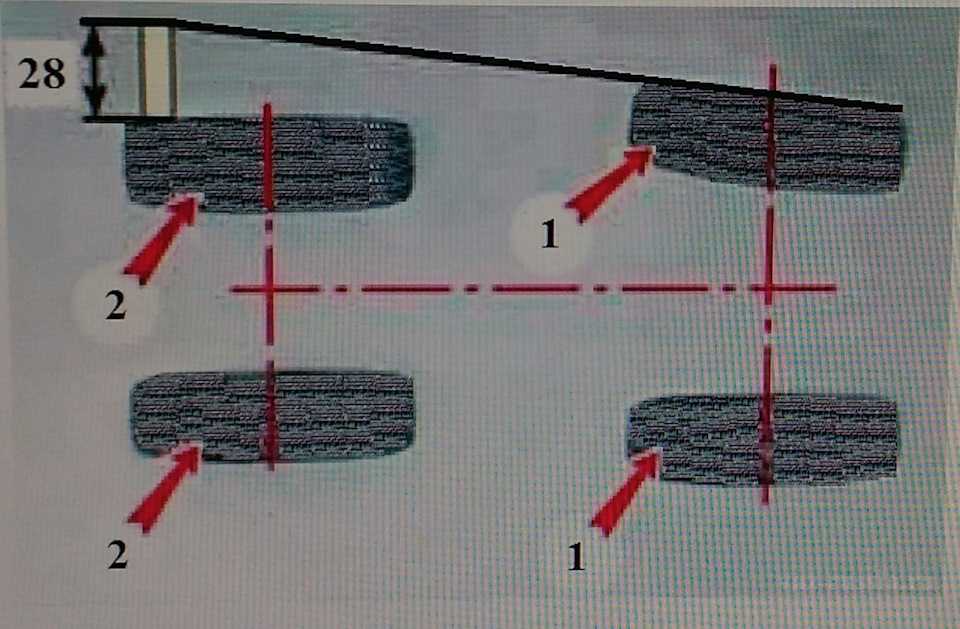

Перед автомобилем (вид сверху). Схождение есть разница расстояний А и В. Если а больше b, то схождение считается положительным. Если меньше b — отрицательный. Для переднеприводных автомобилей схождение на передней оси дает ноль или немного отрицательное значение.

Нормальное схождение передних колес является важным фактором устойчивости автомобиля. Определяется путем расчета разницы между краями шин в их заднем и переднем положениях, измеренной на высоте центра колеса между теми же ободьями. Если разница отличается от рекомендованной, требуется корректировка сходимости.

Точная установка схождения производится только на СТО, после проверки надежности крепления рулевого рычага к поворотной рейке, соединения конусов шаровых шарниров рулевого управления, крепления отбойника и маятникового рычага. Если шасси ремонтировалось, необходимо отрегулировать углы подвески.

Если шасси ремонтировалось, необходимо отрегулировать углы подвески.

Схождение регулируется изменением длины руля. Для этого ослабьте хомуты муфты и поверните регулировочные муфты на одинаковую величину в противоположные стороны, изменяя длину боковой нагрузки. По окончании регулировки зажимы оттягивают так, чтобы их концы после не соприкасались.

Разрезное колесо

Это угол между вертикалью и плоскостью вращения машинного колеса. Если верхняя часть колеса наклонена наружу автомобиля, то угол развала положительный, а если внутрь — отрицательный. Визуально видно на фото (вид машины спереди). Большинство автомобилей производители делают с нуля или с небольшим плюсом. Для гоночных машин — поставить отрицательное значение для улучшения управляемости.

Для проверки развала необходимо, чтобы давление воздуха в шинах было в норме, диски не гнулись, свободный ход руля должен соответствовать норме. Перед проверкой убедитесь в исправности рычагов передней подвески, шаровых опор, штоков амортизаторов.

Развал регулируется изменением количества колодок между осью нижнего рычага и поперечиной или вращением эксцентрика на передней стойке. Также существуют для отечественных автомобилей пластины развала задних колес.

Когда делать?

- После замены деталей подвески (амортизаторы, рулевые тяги).

- Шины неравномерно изнашиваются с внутренней или внешней стороны.

- Попали в яму, проехали по границе, после аварии.

- Часто езжу по плохим дорогам, не устраивает управляемость машины.