Двигатели Шевроле Спарк: технические характеристики, тюнинг

Chevrolet Spark – это типичный городской автомобиль, относящийся к разряду малолитражных. Под данным брендом больше известен в Америке. В остальном мире продается под именем Daewoo Matiz.

В настоящее время выпускается компанией General Motors (Daewoo), находящейся в Южной Корее. Часть транспортных средств собирается по лицензии на некоторых других автозаводах.

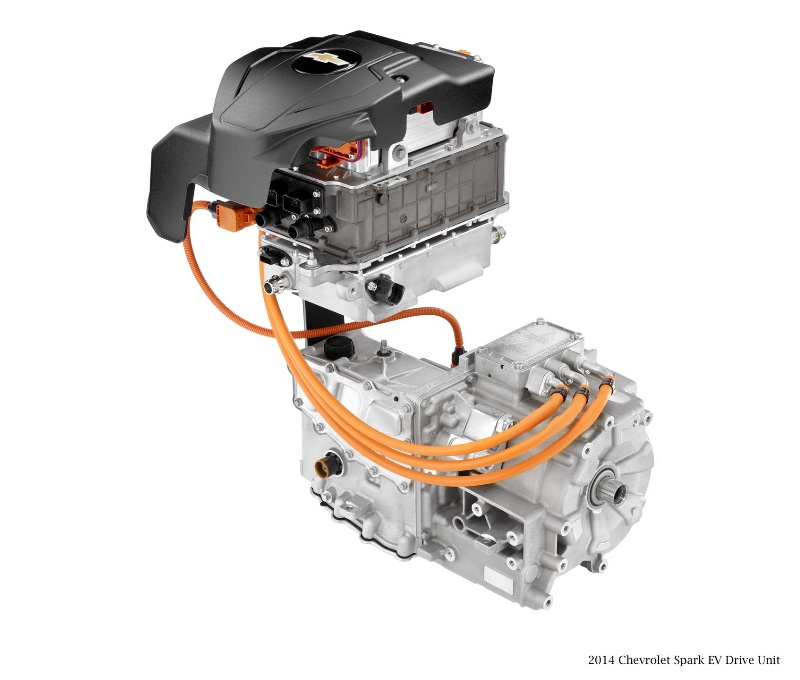

Второе поколение двигателей делится на М200 и М250. М200 впервые был установлен на Spark в 2005 году. От предшественника с Daewoo Matiz (2 поколение) отличается уменьшенным расходом топлива и кузовом с улучшенным коэффициентом аэродинамического сопротивления. ДВС М250 в свою очередь стал использоваться для сборки рестайлинговых Спарков с измененными световыми приборами.

Третье поколение двигателей (М300) появилось на рынке в 2010 году. Устанавливается на кузов длиннее предшественника. Аналогичный применятся при создании Opel Agila и Suzuki Splash. В Южной Корее авто реализуется под маркой Daewoo Matiz Creative. Для Америки и Европы по-прежнему поставляется под брендом Chevrolet Spark, а в России продается как Ravon R2 (узбекская сборка).

В Южной Корее авто реализуется под маркой Daewoo Matiz Creative. Для Америки и Европы по-прежнему поставляется под брендом Chevrolet Spark, а в России продается как Ravon R2 (узбекская сборка).

Четвертое поколение Шевроле Спарк использует двс 3 поколения. Было представлено в 2015 году, а рестайлинг проведен в 2018 году. Изменениям в основном подвергся внешний вид. Также улучшилась техническая начинка. Были добавлены функции Андроид, изменен экстерьер, добавлена система АЕВ.

Содержание

- Какие двигатели устанавливались

- Наиболее популярные двигатели

- Популярность Chevrolet Spark

- Тюнинг двигателя

Какие двигатели устанавливались

| Поколение | Марка, кузов | Годы производства | Двигатель | Мощность, л.с. | Объем, л |

|---|---|---|---|---|---|

| Третье (М300) | Шевроле Спарк, хэтчбек | 2010-15 | B10S1 LL0 | 68 82 84 | 1 1.2 1.2 |

| Второе (М200) | Шевроле Спарк, хэтчбек | 2005-10 | F8CV LA2, B10S | 51 63 | 0. 8 81 |

Наиболее популярные двигатели

Большой востребованностью пользуются моторы, устанавливаемые на поздние версии Шевроле Спарк. Связано это в первую очередь с повышенным объемом и соответственно мощностью. Также на выбор внимание автолюбителей влияют улучшенные динамические характеристики. Не менее важно использование в конструкции улучшенной ходовой части.

Версия автомобиля с 1-литровым мотором и 68 лошадиными силами (B10S1) с первого взгляда отталкивает своей малой мощностью. Несмотря на это вполне уверенно справляется с передвижением авто, которое достаточно бодро разгоняется и уверенно трогается с места. Секрет заключается в измененной трансмиссии, при разработке которой основной упор был сделан на нижние передачи. В результате тяга «на низах» улучшилась, но была потеряна общая скорость.

При достижении 60 км/ч мотор заметно теряет динамику. На 100 км/ч скорость окончательно перестает расти. Тем не менее, подобной динамики достаточно для комфортного передвижения в городе. При этом использование в городе МКПП традиционно менее удобно, чем использование авто с АКПП. Благо Спарк с автоматической коробкой существует в продаже, в том числе и в России.

При этом использование в городе МКПП традиционно менее удобно, чем использование авто с АКПП. Благо Спарк с автоматической коробкой существует в продаже, в том числе и в России.

Самым мощным в гамме двс является LL0 с 1,2 литрами. От менее объемистых «собратьев» радикально не отличается. Для комфортной езды приходится держать двигатель на 4-5 тысячах оборотов. На подобных оборотах проявляет себя не самая лучшая шумоизоляция.

Популярность Chevrolet Spark

Спарк несомненно является одним из лидеров в своем классе. Со времени своего появления был улучшен по основным направлениям. В первую очередь была увеличена колесная база (на 3 см). Теперь высокие пассажиры не подпирают ногами сиденья впереди сидящих пассажиров. В процессе рестайлингов были добавлены емкости различного плана, предназначенные для мобильных телефонов, сигарет, бутылок воды и прочего скарба.

Спарк последних выпусков – это автомобиль с оригинальным стилем. Приборная панель напоминает динамичное сочетание приборов, словно у мотоцикла.

Выводится, например, такая полезная информация как обороты двигателя.

Из минусов, пожалуй, можно отметить оставшийся на прежнем уровне объем багажного отделения (170 л). Дешевые материалы отделки, используемые при выпуске автомобилей, лишний раз указывают на доступность автомобиля.

Уже с 2004 года транспортное средство привлекает своими многочисленными достоинствами. В отдельных комплектациях доступна панорамная крыша, оптика является светодиодной, а 1-литровый двигатель достаточен для небольшого авто. В свое время Спарк (Beat) победил в голосовании такие неплохие авто, как Шевроле Trax и Groove. Что лишний раз доказывает его состоятельность.

Интересен тот факт, что авто 2009 ода выпуска обладает 4 звездами безопасности и набрало 60 из 100 возможных баллов на тестах EuroNCAP. И это при таких небольших размерах и компактности. В основном на снижение уровня безопасности повлияло отсутствие системы ESP. Для сравнения известный многим Daewoo Matiz удостоился на тестах всего 3 звезд безопасности.

Тюнинг двигателя

Агрегат 3 поколения М300 (1,2л) подвергается тюнингу. Для такой цели используется в основном 2 варианта. Первый представляет собой свап атмосферного двигателя объемом 1,8л (F18D3). Второй вариант – установка турбонадува с силой надува от 0,3 до 0,5 бара.

Свап двигателя многими автомастерами считается практически бесполезным. Автолюбители в первую очередь сетуют на большой вес двс. Подобные работы невероятно сложны, да и стоят недешево. При этом дополнительно устанавливается усиленная передняя подвеска, и переделываются тормоза.

Турбирование двигателя более целесообразно, но не менее сложно. Необходимо с большой точностью собрать все детали и проверить на герметичность сам мотор. После установки турбин мощность может повысится на 50 процентов. Но есть одно но – турбина быстро греется и требует остывания. К тому же может буквально разорвать двигатель. В этом плане замена двигателя на F18D3 гораздо безопаснее.

Также на Спарк ставятся моторы объемом 1,6 и 1,8 литра. Предлагается замена родного двигателя на B15D2 и А14NET/NEL. С целью проведения подобного тюнинга лучше обратиться в специализированные автомобильные центры. Иначе есть вероятность просто-напросто испортить двс.

Предлагается замена родного двигателя на B15D2 и А14NET/NEL. С целью проведения подобного тюнинга лучше обратиться в специализированные автомобильные центры. Иначе есть вероятность просто-напросто испортить двс.

Проблемы и надежность 1-литрового двигателя Chevrolet Matiz / Spark

30.05.2021

9220

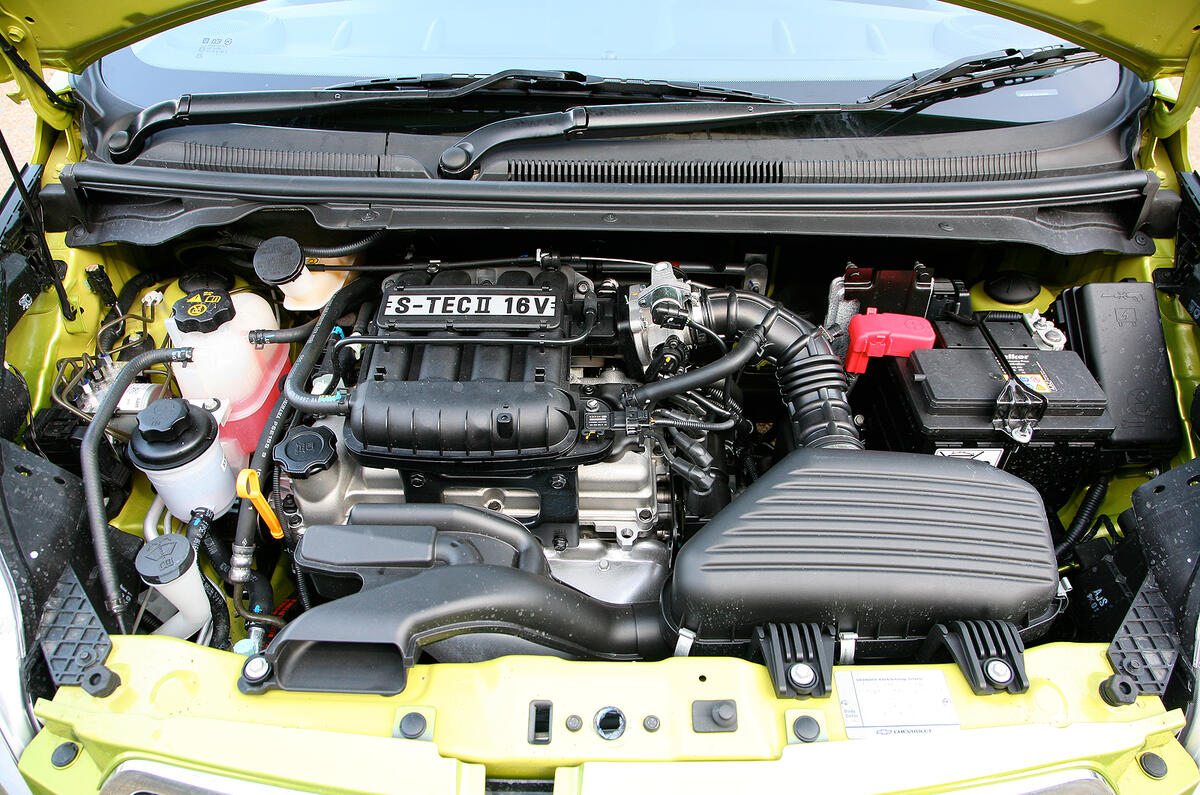

Для «Шевроле Матиз», он же «Спарк», было предложено два двигателя объемом 0,8 и 1,0 литра. Это моторы, соответственно, с тремя и четырьмя цилиндрами. Если не обращать внимание на количество цилиндров, эти силовые практически одинаковые. Диаметр цилиндров – 68,5 мм, ход поршней разный. Ну и не забываем про совершенно разные коленвалы.

Вообще эти двигатели, как и сама платформа Spark / Matiz, происходят от автомобиля Suzuki Alto второго поколения (это модель 1980-х годов).

На нашем YouTube-канале вы можете посмотреть разборку 1-литрового двигателя, снятого с Chevrolet Spark (Matiz) 2008 года выпуска.

youtube.com/embed/bJjciIy76EA»>

Выбрать и купить двигатель для Chevrolet Spark / Matiz вы можете в нашем каталоге контрактных моторов.

Это предельно простой двигатель без замысловатых систем, однако, оснащенный системой EGR. В его ГБЦ один распредвал, который приводит 8 клапанов. Свечи «зажигает» пара сдвоенных катушек зажигания. Двигатель оснащен датчиком абсолютного давления для измерения нагрузки. Дроссельная заслонка во всех вариантах с тросовым приводом, но управление холостым ходом на 3-х и 4-цилиндровом моторе осуществляется разными механизмами.

Плавающие обороты

Двигатель Matiz / Spark может начать троить без видимых причин. Часто причиной плавающих оборотов и нестабильного холостого хода является подсос воздуха. Слабых мест, через которые может просачиваться воздух, на этом двигателе предостаточно. Это, конечно, клапан системы ВКГ, который в исправном состоянии должен пропускать газы только в одну сторону. Также нередко обнаруживается негерметичность шланга к вакуумному усилителю тормозов, подсосы по прокладкам впускного коллектора и дроссельной заслонки.

Также нередко обнаруживается негерметичность шланга к вакуумному усилителю тормозов, подсосы по прокладкам впускного коллектора и дроссельной заслонки.

В зимнее время в шланге системы вентиляции картерных газов на двигателе Matiz может замерзать конденсат из воздуха. Конденсат там скапливается из-за неудачного наклона шланга, не позволяющему влаге вытечь. Разумеется, закупоренный ледяной пробкой шланг приводит к увеличению давления газов в картере, что быстро приводит к выдавливанию сальников и выскакиванию масляного щупа, нередко вместе со значительными порциями масла.

Для борьбы с обмерзанием владельцы «Матизов» выводят шланг отвода картерных газов в корпус воздушного фильтра. Так он лучше защищен от обмерзания, а влага может стекать из шланга на дно корпуса воздушного фильтра.

Клапан ВКГ

Из-за загрязненного клапана ВКГ двигатель Спарк / Матиз может неадекватно себя вести на ходу во момент переключения передач.

Также произвольное повышение оборотов двигателя Спарк / Матиз связано с закупориванием трубки ВКГ замерзшей в ней влагой.

Дроссельная заслонка

Дроссельная заслонка на литровом двигателе Matiz / Spark оснащена оснащена датчиком положения, а регулировка холостого хода осуществляется не клапаном-регулятором, как на 3-цилиндровом двигателе, а управлением положением самой заслонки при помощи электромоторчика. Электронный сервопривод этой заслонки – ее серьезное слабое место. Сам моторчик может выйти из строя, также часто обламываются пластиковые шестерни. В результате пропадает холостой ход, мотор может отказываться запускаться без нажатия на педаль акселератора (при этом заслонка, естественно, открывается).

Знатоки уже научились ремонтировать эти заслонки с заменой моторчика и изношенных шестерен. Однако всегда есть более удобная и недорогая возможность заменить неисправную заслонку на добротную б/у.

Дроссельная заслонка периодически нуждается в чистке. Если мотор держит неровный холостой ход, разгонятся неравномерно или появился провал при разгоне, то следует помыть заслонку подходящим средством.

Выбрать и купить дроссельную заслонку для двигателя Daewoo Matiz или для Chevrolet Spark вы можете в нашем каталоге контрактных запчастей.

Катушка зажигания

Катушка зажигания – слабое место на двигателе Матиз. Катушка ходит около 60 000 км, а потом перестает давать искру на один из цилиндров. Такая неприятность возникает при холодном запуске, проявляется пропусками зажигания и сильным троением двигателя.

Выбрать и купить катушки зажигания для двигателя Chevrolet Spark / Matiz вы можете в нашем каталоге контрактных запчастей.

Форсунки

Загрязнение или снижение производительности одной или нескольких форсунок проявляется едва заметными подрагиваниями двигателя, плавающими оборотами или заметным снижением тяги при разгонах с высокой нагрузкой, т.е. когда Спарк / Матиз разгоняется с максимальным количеством пассажиров.

Выбрать и купить форсунки для двигателя Chevrolet Spark / Matiz вы можете в нашем каталоге контрактных запчастей.

Прокладка в переходнике системы EGR

Система EGR на двигателях Спарк / Матиз выглядит топорно, с кучей лишних элементов. Например, тут есть переходник, соединяющий канал для отбора газов с трубкой их подачи во впускной тракт. На этом же переходнике установлен клапан EGR.

Между переходником и ГБЦ находится крохотная прокладка с двумя отверстиями: под крепежный винт и под канал отбора газов.

Нередко эта прокладка прогорает, и тогда через нее наружу прорываются небольшие порции выхлопных газов. При этом слышен характерный стрекот или цокот. Замена прокладки помогает устранить эту проблему. Но устанавливать и зажимать ее нужно аккуратно, т.к. она может провернуться на единственном крепежном винте.

Если в каналах EGR будет обнаружено масло или масляный налет, то это указывает на попадание масла в камеру сгорания 4-го цилиндра. Именно его, т.к. газы в систему EGR попадают в основном из него. Разумеется, состояние других цилиндров тоже наверняка будет оставлять желать лучшего.

Регулировка клапанов

Проверку тепловых зазоров клапанов нужно проводить каждые 20 000 км. Нередко владельцы забывают об этом. Любопытно, что на новых моторах из Узбекистана регулировка клапанов требовалась уже после обкатки двигателя и до первой смены масла.

О том, что тепловые зазоры «ушли», двигатель сообщает сам. Как правило из-за износа седел поджатыми оказываются выпускные клапана. Из-за этого фазы выпуска немного увеличиваются, а сами клапана перестают держать давление. В результате на холодную возникают пропуски зажигания, мотор будет едва работать. Также нередко наблюдаются хлопки в выхлопной системе.

Ремень ГРМ

Ремень ГРМ на двигателе Спарк / Матиз приводит единственный распредвал и помпу системы охлаждения. Периодичность замены ремня ГРМ всего – 40 000 км. Практика показывает, перепробеги приводят к обрыву ремня, столкновению поршней и клапанов.

Ресурс двигателя Chevrolet Matiz / Spark

Двигатель автомобиля Matiz / Spark редко выхаживает более 200 000 км. Хотя у внимательных владельцев этот мотор может пройти более 300 000 км без капремонта и жора масла.

Как правило, этот двигатель капиталят или меняют из-за залегания поршневых колец, результатом которого является сильный жор масла. Снижение компрессии в 3 раза ниже нормы в одном или нескольких цилиндрах из-за залегания поршневых колец – это довольно распространенная ситуация на этих моторах. Из-за сильного снижения компрессии даже в одном из цилиндров приводит к увеличению давления газов в картере, с которым система ВКГ не справляется. В результате на моторе с залегшими кольцами выдавливает сальники.

Выбрать и купить двигатель для Daewoo или двигатель для Chevrolet вы можете в нашем каталоге контрактных моторов.

Здесь по ссылкам вы можете посмотреть наличие на авторазборке конкретных автомобилей Daewoo или Chevrolet заказать с них автозапчасти.

Вернуться к списку новостей

30.05.20219220

Ремонт двигателя Chevrolet Spark III (M300) в СПб — Eurorepar Авто Премиум

Мы на связи

Хасанская, 5

+7 (812) 325-40-42

Энгельса, 33/1

+7 (812) 326-18-07

Онлайн запись

- Главная

- Ремонт автомобилей

- Двигатель

- Chevrolet

- Spark III (M300)

Выберите ваш автомобиль

Политика конфиденциальности

Когда нужен ремонт двигателя?

Как понять, пришёл час «Х» для мотора или еще нет?

В принципе, тут не никаких премудростей. Мотор, мечтающий о капиталке, сам сообщит нам об этом всевозможными способами:

Мотор, мечтающий о капиталке, сам сообщит нам об этом всевозможными способами:

- повышенный расход масла;

- затрудненный пуск, то есть невозможность запустить мотор с первого раза;

- белый, сизый дым из выхлопной трубы;

- во время движения мотор откровенно плохо «тянет»;

- двигатель периодически начинает дергаться — «троить» и т.п.;

- снижается давление масла;

- пропадает компрессия в цилиндрах.

Любой из этих симптомов служит поводом для «капиталки». Так же критичными могут стать и грубые нарушения условий эксплуатации.

Двигатель: цена за работу

| Услуга | Стоимость |

|---|---|

| Замена двигателя | От 7 500₽ |

| Замена ГБЦ | От 18 000₽ |

| Замена прокладки ГБЦ | От 6 250₽ |

| Замена опоры двигателя | От 950₽ |

| Замена турбины | От 3 750₽ |

| Замена сальника коленвала | От 1 940₽ |

| Замер компрессии в двигателе | От 700₽ |

| Замена маслосъёмных колпачков | От 15 000₽ |

| Замена клапанов | От 25 000₽ |

Цена: От 7 500₽

Длительность: от 5 часов

Подробнее

Цена: От 18 000₽

Длительность: от 6 часов

Подробнее

Цена: От 6 250₽

Длительность: от 4 часов

Подробнее

Цена: От 950₽

Длительность: от 1 часа

Подробнее

Цена: От 3 750₽

Длительность: от 2 часов

Подробнее

Цена: От 1 940₽

Длительность: от 1 часа

Подробнее

Цена: От 700₽

Длительность: от 15 минут

Подробнее

Цена: От 15 000₽

Длительность: от 6 часов

Подробнее

Цена: От 25 000₽

Длительность: от 12 часов

Подробнее

Наши автоцентры

Хасанская, 5

+7 (812) 325-40-42

Энгельса, 33/1

+7 (812) 326-18-07

info@autoservice-ap. ru

ru

Оставить заявку

Ваше имя*

Телефон*

email*

Сообщение

Наши преимущества

Довольных клиентов

0

Заказ-

нарядов

0

Средний

рейтинг

0

Положительных отзывов

99 %

+7 (812) 325-40-42

+7 (812) 326-18-07

О компании

- Работа в условиях COVID-19

- Гарантии

Время работы

Пн-Вс

9.00 — 21.00

© ГК «Авто Премиум» 2022 Все права защищены.

Технические характеристики Chevrolet Spark

Chevrolet Spark L AT

Chevrolet Spark L AT

Chevrolet Spark LS AT

Chevrolet Spark LT AT

КУЗОВ

Тип

Хэтчбек

Количество дверей

5

Количество мест

5

РАЗМЕРЫ

Длина

3640 мм

Ширина

1597 мм

Высота

1522 мм

Колесная база

2375 мм

ДВИГАТЕЛЬ

Рабочий объем

1249 см³

Количество и расположение цилиндров

4, ряд

Максимальная мощность

85,5 при 6400 об.

/мин.

/мин.Макс. крутящий момент

112,5 при 4200 об./мин.

Система питания

Багатоточкове впорскування палива

Тип та марка топлива

А-92 и выше

ТРАНСМИССИЯ

Тип привода

Передний

Коробка передач

4 АТ (автомат)

Тип сцепления

Автоматичное

ОБЪЕМЫ И МАССЫ

Объем топливного бака, л

35

Объем багажника, л

170

Аккумулятор

12V50

Снаряженная масса автомобиля, кг

1054

Допустимая максимальная масса, кг

1363

ПОДВЕСКА

Передняя подвеска

Независимая, тип McPherson

Задняя подвеска

Полузависимая, торсионная

Управление рулем

Электрическое

ДИНАМИЧЕСКИЕ ХАРАКТЕРИСТИКИ

Максимальная скорость, км/час

161

Разгон до 100 км/час с места, cек.

12,4

РАСХОДЫ ТОПЛИВА

Городской, л/100 км

8,2

Смешанный, л/100 км

6,2

КУЗОВ

Тип

Хэтчбек

Количество дверей

5

Количество мест

5

РАЗМЕРЫ

Длина

3640 мм

Ширина

1597 мм

Высота

1522 мм

Колесная база

2375 мм

ДВИГАТЕЛЬ

Рабочий объем

1249 см³

Количество и расположение цилиндров

4, ряд

Максимальная мощность

85,5 при 6400 об.

/мин.

/мин.Макс. крутящий момент

112,5 при 4200 об./мин.

Система питания

Багатоточкове впорскування палива

Тип та марка топлива

А-92 и выше

ТРАНСМИССИЯ

Тип привода

Передний

Коробка передач

4 АТ (автомат)

Тип сцепления

Автоматичное

ОБЪЕМЫ И МАССЫ

Объем топливного бака, л

35

Объем багажника, л

170

Аккумулятор

12V50

Снаряженная масса автомобиля, кг

1054

Допустимая максимальная масса, кг

1363

ПОДВЕСКА

Передняя подвеска

Независимая, тип McPherson

Задняя подвеска

Полузависимая, торсионная

Управление рулем

Электрическое

ДИНАМИЧЕСКИЕ ХАРАКТЕРИСТИКИ

Максимальная скорость, км/час

161

Разгон до 100 км/час с места, cек.

12,4

РАСХОДЫ ТОПЛИВА

Городской, л/100 км

8,2

Смешанный, л/100 км

6,2

КУЗОВ

Тип

Хэтчбек

Количество дверей

5

Количество мест

5

РАЗМЕРЫ

Длина

3640 мм

Ширина

1597 мм

Высота

1522 мм

Колесная база

2375 мм

ДВИГАТЕЛЬ

Рабочий объем

1249 см³

Количество и расположение цилиндров

4, ряд

Максимальная мощность

85,5 при 6400 об.

/мин.

/мин.Макс. крутящий момент

112,5 при 4200 об./мин.

Система питания

Багатоточкове впорскування палива

Тип та марка топлива

А-92 и выше

ТРАНСМИССИЯ

Тип привода

Передний

Коробка передач

4 АТ (автомат)

Тип сцепления

Автоматичное

ОБЪЕМЫ И МАССЫ

Объем топливного бака, л

35

Объем багажника, л

170

Аккумулятор

12V50

Снаряженная масса автомобиля, кг

1054

Допустимая максимальная масса, кг

1363

ПОДВЕСКА

Передняя подвеска

Независимая, тип McPherson

Задняя подвеска

Полузависимая, торсионная

Управление рулем

Электрическое

ДИНАМИЧЕСКИЕ ХАРАКТЕРИСТИКИ

Максимальная скорость, км/час

161

Разгон до 100 км/час с места, cек.

12,4

РАСХОДЫ ТОПЛИВА

Городской, л/100 км

8,2

Смешанный, л/100 км

6,2

Заказать сейчас

Модель Chevrolet Spark, произведенная UzAuto Motors (Узбекистан), — хэтчбек А класса с доступным ценником. Компактные габариты и малый расход топлива — вот главные качества автомобиля, созданного для ежедневных поездок в условиях плотного городского трафика. Изучив характеристики Chevrolet Spark, вы определитесь, подойдет ли машина под ваши требования.

Изучив характеристики Chevrolet Spark, вы определитесь, подойдет ли машина под ваши требования.

Габариты автомобиля

5-дверный хэтчбек позволяет удобно разместиться в салоне четырем пассажирам. Водительское место подойдет для людей с любой комплекцией, что редкость для бюджетных автомобилей.

Размеры Шевроле Спарк

- длина — 3640 мм;

- высота — 1522 мм;

- ширина — 1597 мм;

- колесная база — 2375 мм.

Снаряженная масса авто составляет 1054 кг, допустимая — 1363 кг. Автомобиль имеет компактное багажное отделение, рассчитанное на 170 литров. Объем топливного бака составляет 35 литров, что соответствует компактным габаритам Шевроле Спарк.

Трансмиссия и двигатель

Chevrolet Spark комплектуется 4-ступенчатой автоматической коробкой. Для украинского рынка предусмотрен один рядный четырехцилиндровый бензиновый мотор. Объем двигателя у Спарка составляет 1249 куб см. Двигатель способен выдавать 85 лошадиных сил, максимальный крутящий момент при этом составляет 112,5 Н*м. Производитель рекомендует заправлять автомобиль топливом А-92 или выше.

Производитель рекомендует заправлять автомобиль топливом А-92 или выше.

Подвеска

Сзади хэтчбек оборудован независимой торсионной подвеской. Спереди за комфортное движение отвечает независимая подвеска типа McPherson, отлично вписывающаяся в технические характеристики Chevrolet Spark.

Динамика и расход топлива

Несмотря на малолитражную силовую установку, Chevrolet Spark обладает достойной динамикой: разгон до «сотни» занимает 12,4 секунды. Максимальная скорость составляет 161 км/ч. Динамические характеристики Шевроле Спарк 2021 стали лучше, если сравнивать с конкурентами.

Хэтчбек может похвастаться низким расходом топлива в условиях плотного городского движения — 8,2 литра на 100 км. Смешанный расход — 6,2 л/100 км.

Обзор— документация Spark 3.3.0

Apache Spark — это унифицированный аналитический механизм для крупномасштабной обработки данных.

Он предоставляет API высокого уровня на Java, Scala, Python и R,

и оптимизированный движок, поддерживающий общие графы выполнения. Он также поддерживает богатый набор инструментов более высокого уровня, включая Spark SQL для обработки SQL и структурированных данных, API-интерфейс pandas в Spark для рабочих нагрузок pandas, MLlib для машинного обучения, GraphX для обработки графов и Structured Streaming для добавочных вычислений и потоковой обработки.

Он также поддерживает богатый набор инструментов более высокого уровня, включая Spark SQL для обработки SQL и структурированных данных, API-интерфейс pandas в Spark для рабочих нагрузок pandas, MLlib для машинного обучения, GraphX для обработки графов и Structured Streaming для добавочных вычислений и потоковой обработки.

Загрузите Spark со страницы загрузок веб-сайта проекта. Эта документация предназначена для Spark версии 3.3.0. Spark использует клиентские библиотеки Hadoop для HDFS и YARN. Загрузки предварительно упакованы для нескольких популярных версий Hadoop. Пользователи также могут загрузить двоичный файл «Hadoop free» и запустить Spark с любой версией Hadoop. путем расширения пути к классам Spark. Пользователи Scala и Java могут включать Spark в свои проекты, используя его координаты Maven, а пользователи Python могут устанавливать Spark из PyPI.

Если вы хотите собрать Spark из источник, посетите Building Spark.

Spark работает как в Windows, так и в UNIX-подобных системах (например, Linux, Mac OS) и должен работать на любой платформе, на которой работает поддерживаемая версия Java. Это должно включать JVM на x86_64 и ARM64. Его легко запустить локально на одном компьютере — все, что вам нужно, это установить

Это должно включать JVM на x86_64 и ARM64. Его легко запустить локально на одном компьютере — все, что вам нужно, это установить java в вашей системе PATH или переменную среды JAVA_HOME , указывающую на установку Java.

Spark работает на Java 11.08.17, Scala 2.12/2.13, Python 3.7+ и R 3.5+. Поддержка Java 8 до версии 8u201 устарела, начиная с Spark 3.2.0. Для Scala API Spark 3.3.0 использует Скала 2.12. Вам нужно будет использовать совместимую версию Scala (2.12.х).

Для Python 3.9 оптимизация Arrow и пользовательские функции pandas могут не работать из-за поддерживаемых версий Python в Apache Arrow. Пожалуйста, обратитесь к последней странице совместимости с Python.

Для Java 11 дополнительно требуется -Dio.netty.tryReflectionSetAccessible=true для библиотеки Apache Arrow. Это предотвращает java.lang.UnsupportedOperationException: sun.misc.Unsafe или java.nio.DirectByteBuffer.(long, int) недоступен , когда Apache Arrow использует Netty для внутреннего использования.

Spark поставляется с несколькими примерами программ. Примеры Scala, Java, Python и R находятся в examples/src/основной каталог . Чтобы запустить один из примеров программ Java или Scala, используйте bin/run-example в каталоге Spark верхнего уровня. (За кулисами это

вызывает более общий сценарий spark-submit для

запуск приложений). Например,

./bin/run-example SparkPi 10

Вы также можете запускать Spark в интерактивном режиме через модифицированную версию оболочки Scala. Это отличный способ изучить фреймворк.

./bin/spark-shell --master local[2]

Параметр --master указывает

основной URL для распределенного кластера или локальный для запуска

локально с одним потоком или local[N] для локального запуска с N потоками. Вы должны начать с использования местный для тестирования. Чтобы просмотреть полный список параметров, запустите оболочку Spark с параметром --help .

Spark также предоставляет Python API. Чтобы запустить Spark в интерактивном режиме в интерпретаторе Python, используйте bin/pyspark :

./bin/pyspark --master local[2]

Примеры приложений также доступны на Python. Например,

./bin/spark-submit examples/src/main/python/pi.py 10

Spark также предоставляет R API, начиная с версии 1.4 (включая только API DataFrames).

Чтобы запустить Spark в интерактивном режиме в интерпретаторе R, используйте bin/sparkR :

./bin/sparkR --master local[2]

Примеры приложений также представлены в R. Например,

./bin/spark-submit examples/src/main/r/dataframe.R

В обзоре режима кластера Spark объясняются основные принципы работы в кластере. Spark может работать как сам по себе, так и поверх нескольких существующих менеджеров кластера. В настоящее время он предоставляет несколько вариантов развертывания:

- Автономный режим развертывания: самый простой способ развернуть Spark в частном кластере

- Apache Mesos (устарело)

- ПРЯЖА Hadoop

- Кубернетес

Руководства по программированию:

- Quick Start: краткое введение в Spark API; Начните здесь!

- Руководство по программированию RDD: обзор основ Spark — RDD (базовый, но старый API), аккумуляторы и широковещательные переменные

- Spark SQL, наборы данных и кадры данных: обработка структурированных данных с помощью реляционных запросов (более новый API, чем RDD)

- Structured Streaming: обработка структурированных потоков данных с запросами отношений (с использованием наборов данных и фреймов данных, более новый API, чем DStreams)

- Spark Streaming: обработка потоков данных с использованием DStreams (старый API)

- MLlib: применение алгоритмов машинного обучения

- GraphX: обработка графиков

- SparkR: обработка данных с помощью Spark в R

- PySpark: обработка данных с помощью Spark в Python

- Spark SQL CLI: обработка данных с помощью SQL в командной строке

Документы API:

- Spark Scala API (Scaladoc)

- API Spark Java (Javadoc)

- API Spark Python (Сфинкс)

- API Spark R (Roxygen2)

- Spark SQL, встроенные функции (MkDocs)

Руководства по развертыванию:

- Обзор кластера: обзор концепций и компонентов при работе в кластере

- Отправка приложений: упаковка и развертывание приложений

- Режимы развертывания:

- Amazon EC2: скрипты, позволяющие запустить кластер на EC2 примерно за 5 минут

- Режим автономного развертывания: быстрый запуск автономного кластера без стороннего диспетчера кластера

- Mesos: разверните частный кластер с помощью Апач Месос

- YARN: разверните Spark поверх Hadoop NextGen (YARN)

- Kubernetes: разверните Spark поверх Kubernetes

Прочие документы:

- Конфигурация: настройка Spark через систему конфигурации

- Мониторинг: отслеживайте поведение ваших приложений

- Руководство по настройке: рекомендации по оптимизации производительности и использования памяти

- Планирование заданий: планирование ресурсов между приложениями Spark и внутри них

- Безопасность: поддержка безопасности Spark

- Подготовка оборудования: рекомендации по кластерному оборудованию

- Интеграция с другими СХД:

- Облачные инфраструктуры

- OpenStack Swift

- Руководство по миграции: руководства по миграции для компонентов Spark

- Building Spark: сборка Spark с использованием системы Maven

- Участие в Spark

- Сторонние проекты: связанные сторонние проекты Spark

Внешние ресурсы:

- Домашняя страница Spark

- Ресурсы сообщества Spark, включая местные встречи

- Тег StackOverflow

apache-spark - Списки рассылки: задавайте вопросы о Spark здесь

- AMP Camps: серия тренировочных лагерей в Калифорнийском университете в Беркли, в ходе которых

упражнения о Spark, Spark Streaming, Mesos и многом другом.

Видео,

доступны онлайн бесплатно. Примеры кода

Видео,

доступны онлайн бесплатно. Примеры кода - : дополнительные примеры также доступны в подпапке

примеровSpark (Scala, Ява, питон, Р)

Обучение управлению продуктами Spark Engine и сертификация — Главная

Мастер управления продуктами с упором на инновации и влияние.

Получите реальный опыт работы с продуктом и развивайте свою карьеру с помощью индивидуального коучинга по продуктам

Учитесь на практике

Это не традиционная программа обучения! Это практическое, совместное, личное…

Программы Spark Engine в области управления продуктами и инновациями дают вам как знания, так и опыт для разработки и запуска эффективных продуктов — цифровых, физических или услуг. Изучите нелинейные, не зависящие от процессов фреймворки, которые помогут вам разрабатывать новые идеи, развивать существующие продукты и внедрять инновации в компаниях любого размера.

CPIP: 3 дня совместного обучения + 6 недель индивидуального коучинга при работе над реальной проблемой.

Хотите узнать о новых методах управления продуктами?

Управление продукцией — одна из самых быстрорастущих ролей в компаниях любого размера.

Если вы новичок в продукте или хотите отточить свои навыки и выйти на новый уровень, мы обеспечиваем совместное обучение на основе опыта и экспертное руководство по созданию эффективных инновационных продуктов на любом этапе.

Хотите лидировать с инновационным мышлением?

Инновации возникают благодаря глубокому пониманию потребностей клиентов и открытию неиспользованных возможностей в сочетании с новым мышлением.

Мы даем вам инструменты и схемы для переосмысления и переформулирования проблем, создания новых точек зрения и постановки вопросов, стимулирующих инновации.

Хотите развиваться в своей карьере?

Продемонстрируйте экспертные знания в области методов и основ управления продуктами с сертификацией Spark Engine.

Сертификация подтверждает не только знания, но и опыт реализации новых продуктов от идеи до запуска.

Присоединяйтесь к семинару

Загрузите руководство для учащихся CPIP, чтобы узнать больше о программе Certified Product Innovation Professional (CPIP), или отправьте заявку, чтобы узнать, подходит ли она вам и вашим потребностям.

Зарегистрируйтесь на предстоящий курс или подайте заявку.

Мы делаем по-другому

Учитесь, делая

Все программы основаны на опыте. Благодаря практическому опыту и индивидуальному коучингу мы помогаем вам развивать свои навыки управления продуктами с помощью инновационных структур и стратегического проектирования. Эта специализация поможет вам оказывать влияние и разрабатывать продукты для любой организации.

Экспертное руководство

Наши опытные тренеры привносят реальный опыт в каждое занятие. Они являются руководителями продуктов, инновационными стратегами и лидерами дизайна в различных отраслях. С помощью практических упражнений они помогут вам изучить и применить инновационные концепции к вашим собственным продуктам, уделяя особое внимание оказанию значимого воздействия.

С помощью практических упражнений они помогут вам изучить и применить инновационные концепции к вашим собственным продуктам, уделяя особое внимание оказанию значимого воздействия.

Получить сертификат

Сертификация Spark Engine подтверждает ваши знания и опыт в области управления продуктами и внедрения инноваций. Программы Spark Engine предназначены для того, чтобы дать вам опыт и глубокое базовое обучение, чтобы стать эффективным новатором продукта.

Для кого мы?

Мы предлагаем публичные занятия для тех, кто хочет углубить свои знания о продуктах и внедрить инновационные методы в свою повседневную работу. Мы также работаем с организациями по всему миру, внедряющими индивидуальные программы в области управления продуктами и инноваций

Для отдельных лиц

Выделите себя, развивайтесь профессионально, изучайте новые методы создания инновационных продуктов, становитесь человеком, который постоянно обеспечивает впечатляющий опыт

Для команд

Возможно, вы запускаете новый продукт или боретесь с уже существующим на рынке продуктом, и вам нужен способ чтобы скорректировать курс и ускорить доставку

Для организаций

Каждая команда должна быть инновационной. Вы хотите ускорить внедрение инноваций, способствовать творчеству и расширить возможности команд с помощью проверенной системы, которую можно применить к любому проекту

Вы хотите ускорить внедрение инноваций, способствовать творчеству и расширить возможности команд с помощью проверенной системы, которую можно применить к любому проекту

Что говорят студенты?

Отзывы некоторых наших студентов

«Это помогло мне сосредоточиться на вещах, которые я упускал из виду при повседневном управлении продуктом. Также есть несколько удивительных новых методов для решения врожденных повседневных проблем и предоставления свежего взгляда на управление проектами».

«Курс Product Innovation Professional был веселым и увлекательным, и вы уходите с набором инструментов, полным лучших практик, которые можно мгновенно применить для улучшения практически любой работы. Валерио и Зейна хорошо осведомлены и доступны, и я бы порекомендовал этот курс всем, кто хочет создавать отличные продукты».

«Если вы ищете всеобъемлющую структуру, которая поможет вам в процессе инноваций, это то, что вам нужно. Отличные инструменты, отраслевые инструкции и полезная документация, которую можно сразу же использовать».

«Это была совершенно новая тема для меня. Я узнал много полезных инструментов и техник, которые уже применяю в своем бизнесе. Я вижу в этом эффективный способ снизить риск и повысить ценность для клиентов каждый раз, когда запускаю новый продукт или услугу. Спасибо”

Стать сертифицированным специалистом по инновациям продуктов

Программа CPIP ( сертифицированный специалист по инновациям продуктов ) представляет собой 6-недельный мастер-класс по управлению продуктами и инновациям.

Вы приобретаете опыт, чтобы придумывать, проверять и создавать новые продукты, работая над реальной идеей продукта. Наши опытные тренеры и тренеры работают с вами на протяжении всей программы, чтобы поддержать ваше развитие и рост.

Вы тренер?

У вас есть страсть делиться своим опытом в области продуктов и помогать другим изучать методы управления продуктами? Станьте сертифицированным тренером по инновациям (CPIT) и реализуйте программы Spark Engine.

CPIT — это высший уровень сертификации Spark Engine, который присуждается тем, у кого есть отраслевой опыт в создании и запуске новых продуктов, а также стремление делиться своим опытом с другими для дальнейшего роста.

Что такое Apache Spark? Платформа больших данных, которая разгромила Hadoop

Быстрая, гибкая и удобная для разработчиков Apache Spark — ведущая платформа для крупномасштабного SQL, пакетной обработки, потоковой обработки и машинного обучения

Ян Пойнтер

Информационный Мир |

красный волк518сток (КК BY 3.0)Apache Spark определено

Apache Spark — это платформа обработки данных, которая может быстро выполнять задачи обработки очень больших наборов данных, а также может распределять задачи обработки данных между несколькими компьютерами либо самостоятельно, либо в тандеме с другими инструментами распределенных вычислений. Эти два качества являются ключевыми в мире больших данных и машинного обучения, которые требуют объединения огромных вычислительных мощностей для работы с большими хранилищами данных. Spark также снимает часть бремени программирования этих задач с плеч разработчиков с помощью простого в использовании API, который абстрагирует большую часть рутинной работы распределенных вычислений и обработки больших данных.

Эти два качества являются ключевыми в мире больших данных и машинного обучения, которые требуют объединения огромных вычислительных мощностей для работы с большими хранилищами данных. Spark также снимает часть бремени программирования этих задач с плеч разработчиков с помощью простого в использовании API, который абстрагирует большую часть рутинной работы распределенных вычислений и обработки больших данных.

С момента своего скромного появления в лаборатории AMPLab в Калифорнийском университете. Беркли в 2009 году, Apache Spark стал одной из ключевых сред распределенной обработки больших данных в мире. Spark можно развернуть различными способами, он предоставляет собственные привязки для языков программирования Java, Scala, Python и R, а также поддерживает SQL, потоковую передачу данных, машинное обучение и обработку графов. Вы обнаружите, что его используют банки, телекоммуникационные компании, игровые компании, правительства и все крупные технологические гиганты, такие как Apple, Facebook, IBM и Microsoft.

Архитектура Apache Spark

На фундаментальном уровне приложение Apache Spark состоит из двух основных компонентов: драйвера , , который преобразует пользовательский код в несколько задач, которые могут быть распределены между рабочими узлами, и исполнителей, которые выполняют на этих узлах и выполнять поставленные перед ними задачи. Некоторая форма менеджера кластера необходима для посредничества между ними.

По умолчанию Spark может работать в автономном кластерном режиме, для чего просто требуется среда Apache Spark и JVM на каждой машине в вашем кластере. Однако более вероятно, что вы захотите воспользоваться преимуществами более надежной системы управления ресурсами или кластерами, чтобы позаботиться о выделении рабочих ресурсов по запросу. На предприятии это обычно означает работу с Hadoop YARN (именно так дистрибутивы Cloudera и Hortonworks запускают задания Spark), но Apache Spark также может работать на Apache Mesos, Kubernetes и Docker Swarm.

Если вы ищете управляемое решение, то Apache Spark можно найти как часть Amazon EMR, Google Cloud Dataproc и Microsoft Azure HDInsight. Databricks, компания, в которой работают основатели Apache Spark, также предлагает платформу унифицированной аналитики Databricks, которая представляет собой комплексную управляемую услугу, которая предлагает кластеры Apache Spark, поддержку потоковой передачи, интегрированную разработку веб-блокнотов и оптимизированную производительность облачного ввода-вывода по сравнению с стандартный дистрибутив Apache Spark.

Apache Spark преобразует пользовательские команды обработки данных в Направленный ациклический граф или DAG. DAG — это уровень планирования Apache Spark; он определяет, какие задачи выполняются на каких узлах и в какой последовательности.

Spark по сравнению с Hadoop: зачем использовать Apache Spark?

Стоит отметить, что Apache Spark и Apache Hadoop — это несколько неправильное название. В наши дни вы найдете Spark в большинстве дистрибутивов Hadoop. Но благодаря двум большим преимуществам Spark стал предпочтительным фреймворком при обработке больших данных, обогнав старую парадигму MapReduce, которая сделала Hadoop популярным.

Но благодаря двум большим преимуществам Spark стал предпочтительным фреймворком при обработке больших данных, обогнав старую парадигму MapReduce, которая сделала Hadoop популярным.

Первое преимущество — скорость. Механизм обработки данных в памяти Spark означает, что в определенных ситуациях он может выполнять задачи в сто раз быстрее, чем MapReduce, особенно по сравнению с многоэтапными заданиями, требующими записи состояния на диск между этапами. По сути, MapReduce создает двухэтапный граф выполнения, состоящий из сопоставления и сокращения данных, тогда как DAG Apache Spark имеет несколько этапов, которые можно распределять более эффективно. Даже задания Apache Spark, в которых данные не могут быть полностью помещены в память, обычно выполняются примерно в 10 раз быстрее, чем их аналог MapReduce.

Второе преимущество — удобный для разработчиков Spark API. Каким бы важным ни было ускорение Spark, можно утверждать, что удобство Spark API еще важнее.

Spark Core

По сравнению с MapReduce и другими компонентами Apache Hadoop API-интерфейс Apache Spark очень удобен для разработчиков, скрывая большую часть сложности механизма распределенной обработки за простыми вызовами методов. Каноническим примером этого является то, как почти 50 строк кода MapReduce для подсчета слов в документе можно сократить до нескольких строк Apache Spark (здесь показано на Scala):

Каноническим примером этого является то, как почти 50 строк кода MapReduce для подсчета слов в документе можно сократить до нескольких строк Apache Spark (здесь показано на Scala):

val textFile = sparkSession.sparkContext.textFile("hdfs:///tmp/words")

val counts = textFile.flatMap(line => line.split(" "))

.map(word => (word , 1))

.reduceByKey(_ + _)

counts.saveAsTextFile("hdfs:///tmp/words_agg") Предоставляя привязки к популярным языкам для анализа данных, таким как Python и R, а также к более корпоративным с поддержкой Java и Scala, Apache Spark позволяет всем, от разработчиков приложений до специалистов по данным, использовать его масштабируемость и скорость доступным способом.

Spark RDD

В основе Apache Spark лежит концепция Resilient Distributed Dataset (RDD) — программная абстракция, представляющая собой неизменяемый набор объектов, которые можно разделить в вычислительном кластере. Операции с RDD также могут быть разделены по всему кластеру и выполняться в параллельном пакетном процессе, что обеспечивает быструю и масштабируемую параллельную обработку.

Операции с RDD также могут быть разделены по всему кластеру и выполняться в параллельном пакетном процессе, что обеспечивает быструю и масштабируемую параллельную обработку.

RDD можно создавать из простых текстовых файлов, баз данных SQL, хранилищ NoSQL (таких как Cassandra и MongoDB), корзин Amazon S3 и многого другого. Большая часть API-интерфейса Spark Core построена на этой концепции RDD, обеспечивая традиционную функциональность сопоставления и сокращения, а также предоставляя встроенную поддержку для объединения наборов данных, фильтрации, выборки и агрегирования.

Spark работает распределенным образом, объединяя основной процесс драйвера , который разбивает приложение Spark на задачи и распределяет их между множеством процессов исполнителя , выполняющих работу. Эти исполнители могут масштабироваться вверх и вниз по мере необходимости для нужд приложения.

Spark SQL

Первоначально известный как Shark, Spark SQL становится все более и более важным для проекта Apache Spark. Вероятно, это интерфейс, наиболее часто используемый сегодняшними разработчиками при создании приложений. Spark SQL ориентирован на обработку структурированных данных с использованием подхода к кадрам данных, заимствованного из R и Python (в Pandas). Но, как следует из названия, Spark SQL также предоставляет совместимый с SQL2003 интерфейс для запроса данных, предоставляя возможности Apache Spark как аналитикам, так и разработчикам.

Вероятно, это интерфейс, наиболее часто используемый сегодняшними разработчиками при создании приложений. Spark SQL ориентирован на обработку структурированных данных с использованием подхода к кадрам данных, заимствованного из R и Python (в Pandas). Но, как следует из названия, Spark SQL также предоставляет совместимый с SQL2003 интерфейс для запроса данных, предоставляя возможности Apache Spark как аналитикам, так и разработчикам.

Помимо стандартной поддержки SQL, Spark SQL предоставляет стандартный интерфейс для чтения и записи в другие хранилища данных, включая JSON, HDFS, Apache Hive, JDBC, Apache ORC и Apache Parquet, все из которых поддерживаются по умолчанию. Другие популярные магазины — Apache Cassandra, MongoDB, Apache HBase и многие другие — можно использовать, подключив отдельные коннекторы из экосистемы Spark Packages.

Выбор некоторых столбцов из фрейма данных так же прост, как эта строка:

cityDF.select("name", "pop") Используя интерфейс SQL, мы регистрируем фрейм данных как временную таблицу, после чего можем выполнять к ней SQL-запросы:

cityDF.createOrReplaceTempView("cities")

spark.sql("SELECT name, pop FROM city")

За кулисами Apache Spark использует оптимизатор запросов под названием Catalyst, который проверяет данные и запросы, чтобы создать эффективный план запросов для локализации данных и вычислений, которые будут выполнять необходимые вычисления в кластере. В эпоху Apache Spark 2.x интерфейс Spark SQL для фреймов данных и наборов данных (по сути, типизированный фрейм данных, который можно проверить во время компиляции на правильность и воспользоваться преимуществами дополнительной оптимизации памяти и вычислений во время выполнения) является рекомендуемым подходом для разработки. . Интерфейс RDD по-прежнему доступен, но рекомендуется, только если ваши потребности не могут быть удовлетворены в рамках парадигмы Spark SQL.

Spark 2.4 представил набор встроенных функций высшего порядка для прямого управления массивами и другими типами данных более высокого порядка.

Spark MLlib

Apache Spark также включает библиотеки для применения методов машинного обучения и анализа графов к данным в масштабе. Spark MLlib включает в себя платформу для создания конвейеров машинного обучения, позволяющую легко реализовать извлечение признаков, выборку и преобразование в любом структурированном наборе данных. MLlib поставляется с распределенными реализациями алгоритмов кластеризации и классификации, таких как кластеризация k-средних и случайные леса, которые можно легко переключать в пользовательские конвейеры и из них. Специалисты по данным могут обучать модели в Apache Spark с использованием R или Python, сохранять их с помощью MLlib, а затем импортировать в конвейер на основе Java или Scala для использования в производстве.

Spark MLlib включает в себя платформу для создания конвейеров машинного обучения, позволяющую легко реализовать извлечение признаков, выборку и преобразование в любом структурированном наборе данных. MLlib поставляется с распределенными реализациями алгоритмов кластеризации и классификации, таких как кластеризация k-средних и случайные леса, которые можно легко переключать в пользовательские конвейеры и из них. Специалисты по данным могут обучать модели в Apache Spark с использованием R или Python, сохранять их с помощью MLlib, а затем импортировать в конвейер на основе Java или Scala для использования в производстве.

Обратите внимание, что, хотя Spark MLlib охватывает базовое машинное обучение, включая классификацию, регрессию, кластеризацию и фильтрацию, он не включает средства для моделирования и обучения глубоких нейронных сетей (подробности см. в обзоре Spark MLlib от InfoWorld). Тем не менее, конвейеры глубокого обучения находятся в разработке.

Spark GraphX

Spark GraphX поставляется с набором распределенных алгоритмов для обработки графовых структур, включая реализацию Google PageRank. Эти алгоритмы используют RDD-подход Spark Core к моделированию данных; пакет GraphFrames позволяет вам выполнять графовые операции с фреймами данных, включая использование оптимизатора Catalyst для графических запросов.

Эти алгоритмы используют RDD-подход Spark Core к моделированию данных; пакет GraphFrames позволяет вам выполнять графовые операции с фреймами данных, включая использование оптимизатора Catalyst для графических запросов.

Spark Streaming

Spark Streaming был ранним дополнением к Apache Spark, которое помогло ему завоевать популярность в средах, требующих обработки в режиме реального или близкого к реальному времени. Раньше пакетная и потоковая обработка в мире Apache Hadoop были разными вещами. Вы должны написать код MapReduce для своих нужд пакетной обработки и использовать что-то вроде Apache Storm для ваших требований к потоковой передаче в реальном времени. Это, очевидно, приводит к разрозненным базам кода, которые необходимо синхронизировать для домена приложения, несмотря на то, что они основаны на совершенно разных платформах, требуют разных ресурсов и связаны с разными операционными проблемами для их запуска.

Spark Streaming расширил концепцию пакетной обработки Apache Spark до потоковой передачи, разбив поток на непрерывную серию микропакетов, которыми затем можно было манипулировать с помощью API Apache Spark. Таким образом, код в пакетных и потоковых операциях может совместно использовать (в основном) один и тот же код, работающий в одной и той же среде, что снижает накладные расходы как разработчика, так и оператора. Все выигрывают.

Таким образом, код в пакетных и потоковых операциях может совместно использовать (в основном) один и тот же код, работающий в одной и той же среде, что снижает накладные расходы как разработчика, так и оператора. Все выигрывают.

Критика подхода Spark Streaming заключается в том, что микропакетная обработка в сценариях, где требуется отклик с малой задержкой на входящие данные, может не соответствовать производительности других платформ с потоковой передачей, таких как Apache Storm, Apache Flink и Apache. Apex, все из которых используют метод чистой потоковой передачи, а не микропакеты.

Структурированная потоковая передача

Структурированная потоковая передача (добавлена в Spark 2.x) для Spark Streaming — это то же самое, что Spark SQL для Spark Core API: API более высокого уровня и более простая абстракция для написания приложений. В случае Structure Streaming высокоуровневый API позволяет разработчикам создавать бесконечные потоковые кадры данных и наборы данных. Это также решает некоторые очень серьезные проблемы, с которыми пользователи боролись в более ранней структуре, особенно в отношении работы с агрегированием времени события и поздней доставкой сообщений. Все запросы к структурированным потокам проходят через оптимизатор запросов Catalyst и даже могут выполняться в интерактивном режиме, что позволяет пользователям выполнять SQL-запросы к потоковым данным в реальном времени.

Это также решает некоторые очень серьезные проблемы, с которыми пользователи боролись в более ранней структуре, особенно в отношении работы с агрегированием времени события и поздней доставкой сообщений. Все запросы к структурированным потокам проходят через оптимизатор запросов Catalyst и даже могут выполняться в интерактивном режиме, что позволяет пользователям выполнять SQL-запросы к потоковым данным в реальном времени.

Структурированная потоковая передача изначально основывалась на микропакетной схеме Spark Streaming для обработки потоковых данных. Но в Spark 2.3 команда Apache Spark добавила режим непрерывной обработки с малой задержкой в структурированную потоковую передачу, что позволяет обрабатывать ответы с задержкой до 1 мс, что очень впечатляет. Начиная со Spark 2.4, непрерывная обработка по-прежнему считается экспериментальной. В то время как структурированная потоковая передача построена на основе ядра Spark SQL, непрерывная потоковая передача поддерживает только ограниченный набор запросов.

Структурированная потоковая передача — это будущее потоковых приложений с платформой, поэтому, если вы создаете новое потоковое приложение, вам следует использовать структурированную потоковую передачу. Устаревшие API-интерфейсы Spark Streaming будут по-прежнему поддерживаться, но проект рекомендует перенести на Structured Streaming, поскольку новый метод делает написание и поддержку кода потоковой передачи намного более терпимым.

Конвейеры глубокого обучения

Apache Spark поддерживает глубокое обучение с помощью конвейеров глубокого обучения. Используя существующую конвейерную структуру MLlib, вы можете вызывать низкоуровневые библиотеки глубокого обучения и создавать классификаторы всего за несколько строк кода, а также применять к входящим данным пользовательские графики TensorFlow или модели Keras. Эти графики и модели можно даже зарегистрировать как пользовательские UDF Spark SQL (определяемые пользователем функции), чтобы модели глубокого обучения можно было применять к данным как часть операторов SQL.

Руководства по Apache Spark

Готовы погрузиться и изучить Apache Spark? Мы настоятельно рекомендуем книгу Эвана Хейтмана «Руководство неандертальца по Apache Spark на Python», в которой не только излагаются основы работы Apache Spark в относительно простых терминах, но также проводится процесс написания простого приложения Python, использующего фреймворк. . Статья написана с точки зрения специалиста по данным, что имеет смысл, поскольку наука о данных — это мир, в котором большие данные и машинное обучение приобретают все большее значение.

Если вам нужны примеры Apache Spark, чтобы дать вам представление о том, что может делать платформа и как она это делает, посмотрите Spark By {Examples}. Здесь есть множество примеров кода для ряда основных задач, которые составляют строительные блоки программирования Spark, поэтому вы можете увидеть компоненты, которые составляют более крупные задачи, для которых создан Apache Spark.

Нужно углубиться? У DZone есть то, что он скромно называет Полная коллекция Apache Spark, которая состоит из множества полезных руководств по многим темам Apache Spark. Приятного обучения!

Приятного обучения!

Связанный:

- Аналитика

- Большие данные

- SQL

- Машинное обучение

- Хадуп

- Открытый исходный код

- Разработка программного обеспечения

Ян Пойнтер — старший архитектор больших данных и глубокого обучения, работающий с Apache Spark и PyTorch. Он имеет более чем 15-летний опыт разработки и эксплуатации.

Copyright © 2020 IDG Communications, Inc.

Как выбрать платформу разработки с низким кодом

Spark 101: что это такое, что оно делает и почему это важно

Информация об исходном сообщении:

"опубликовать": "2018-10-17T08:00:00.000Z", "tags": "spark"

В этом сообщении блога мы познакомим вас с Apache Spark и его историей, а также рассмотрим некоторые области, в которых его конкретный набор возможностей демонстрирует наибольшую перспективу. Мы обсудим связь с другими ключевыми технологиями и предоставим несколько полезных советов.

Мы обсудим связь с другими ключевыми технологиями и предоставим несколько полезных советов.

В Spark 2.0 и более поздних версиях были реализованы большие улучшения, чтобы упростить программирование и ускорить выполнение Spark.

Что такое Apache Spark?

Spark — это механизм распределенной обработки данных общего назначения, который подходит для использования в самых разных условиях. Помимо основного механизма обработки данных Spark, существуют библиотеки для SQL, машинного обучения, вычислений графов и потоковой обработки, которые можно использовать вместе в приложении. Языки программирования, поддерживаемые Spark, включают: Java, Python, Scala и R. Разработчики приложений и специалисты по данным включают Spark в свои приложения для быстрого запроса, анализа и преобразования данных в нужном масштабе. Задачи, наиболее часто связанные со Spark, включают пакетные задания ETL и SQL для больших наборов данных, обработку потоковых данных с датчиков, IoT или финансовых систем, а также задачи машинного обучения.

История

Чтобы понять Spark, нужно понять его историю. До Spark существовала MapReduce, отказоустойчивая распределенная среда обработки, которая позволяла Google индексировать стремительно растущие объемы контента в Интернете на больших кластерах обычных серверов.

В стратегии Google было 3 основных понятия:

Распространение данных: когда файл данных загружается в кластер, он разбивается на фрагменты, называемые блоками данных, и распределяется между узлами данных и реплицируется между ними. кластер.

Распределение вычислений: пользователя задают функцию сопоставления, которая обрабатывает пару ключ/значение для создания набора промежуточных пар ключ/значение, и функцию сокращения, которая объединяет все промежуточные значения, связанные с одним и тем же промежуточным ключом. Программы, написанные в этом функциональном стиле, автоматически распараллеливаются и выполняются на большом кластере стандартных машин следующим образом:

- Процесс сопоставления выполняется для каждого назначенного узла данных, работая только с его блоком данных из распределенного файла.

- Результаты процессов сопоставления отправляются редюсерам в процессе, называемом «перемешивание и сортировка»: пары ключ/значение от преобразователей сортируются по ключу, разбиваются по количеству редьюсеров, а затем отправляются по сети и записываются для отсортированных по ключу «файлов последовательности» на узлах редуктора.

- Процесс редьюсера выполняется на назначенном ему узле и работает только со своим подмножеством данных (своим файлом последовательности). Выходные данные процесса редуктора записываются в выходной файл.

- Процесс сопоставления выполняется для каждого назначенного узла данных, работая только с его блоком данных из распределенного файла.

Допускать сбои: и данные, и вычисления могут допускать сбои за счет переключения на другой узел для данных или обработки.

Пример выполнения подсчета слов MapReduce:

Некоторые итерационные алгоритмы, такие как PageRank, который Google использовал для ранжирования веб-сайтов в результатах поиска, требуют объединения нескольких заданий MapReduce, что приводит к большому количеству операций чтения и записи на диск. . Когда несколько заданий MapReduce объединены в цепочку, для каждого задания MapReduce данные считываются из блока распределенного файла в процесс сопоставления, записываются в SequenceFile и считываются из него, а затем записываются в выходной файл из процесса сокращения.

. Когда несколько заданий MapReduce объединены в цепочку, для каждого задания MapReduce данные считываются из блока распределенного файла в процесс сопоставления, записываются в SequenceFile и считываются из него, а затем записываются в выходной файл из процесса сокращения.

Через год после того, как Google опубликовал официальный документ с описанием инфраструктуры MapReduce (2004), Дуг Каттинг и Майк Кафарелла создали Apache Hadoop™.

Apache Spark™ начал свою жизнь в 2009 году как проект в рамках AMPLab Калифорнийского университета в Беркли. Spark стал инкубационным проектом Apache Software Foundation в 2013 году, а в начале 2014 года он стал одним из проектов высшего уровня Foundation. В настоящее время Spark является одним из наиболее активных проектов, управляемых Фондом, и сообщество, выросшее вокруг проекта, включает в себя как активных индивидуальных участников, так и хорошо финансируемых корпоративных спонсоров, таких как Databricks, IBM и китайская Huawei.

Целью проекта Spark было сохранить преимущества масштабируемой, распределенной, отказоустойчивой среды обработки MapReduce, сделав ее более эффективной и простой в использовании. Преимущества Spark по сравнению с MapReduce:

- Spark выполняется намного быстрее за счет кэширования данных в памяти для нескольких параллельных операций, тогда как MapReduce требует больше операций чтения и записи с диска.

- Spark выполняет многопоточные задачи внутри процессов JVM, тогда как MapReduce работает как более тяжелые процессы JVM. Это обеспечивает более быстрый запуск Spark, лучший параллелизм и лучшую загрузку ЦП.

- Spark предоставляет более богатую модель функционального программирования, чем MapReduce.

- Spark особенно полезен для параллельной обработки распределенных данных с итеративными алгоритмами .

Как приложение Spark работает в кластере

На приведенной ниже диаграмме показано приложение Spark, работающее в кластере.

- Приложение Spark запускается как независимые процессы, координируемые объектом SparkSession в программе-драйвере.

- Менеджер ресурсов или кластера назначает задачи рабочим, по одной задаче на раздел.

- Задача применяет свою единицу работы к набору данных в своем разделе и выводит новый набор данных раздела. Поскольку итерационные алгоритмы многократно применяют операции к данным, они выигрывают от кэширования наборов данных между итерациями.

- Результаты отправляются обратно в приложение драйвера или могут быть сохранены на диск.

Spark поддерживает следующие менеджеры ресурсов/кластеров:

- Spark Standalone — простой менеджер кластеров, включенный в Spark

- Apache Mesos — общий менеджер кластера, который также может запускать приложения Hadoop

- Apache Hadoop YARN — менеджер ресурсов в Hadoop 2 контейнерные приложения

Spark также имеет локальный режим, в котором драйвер и исполнители работают как потоки на вашем компьютере, а не как кластер, что полезно для разработки ваших приложений с персонального компьютера.

Что делает искра?

Spark может обрабатывать несколько петабайт данных за раз, распределенных по кластеру из тысяч взаимодействующих физических или виртуальных серверов. Он имеет обширный набор библиотек для разработчиков и API и поддерживает такие языки, как Java, Python, R и Scala; его гибкость делает его подходящим для целого ряда вариантов использования. Spark часто используется с распределенными хранилищами данных, такими как HPE Ezmeral Data Fabric, HDFS Hadoop и Amazon S3, с популярными базами данных NoSQL, такими как HPE Ezmeral Data Fabric, Apache HBase, Apache Cassandra и MongoDB, а также с распределенными хранилищами сообщений, такими как HPE. Ezmeral Data Fabric и Apache Kafka.

Типичные варианты использования включают:

Потоковая обработка: От файлов журналов до данных датчиков разработчикам приложений все чаще приходится справляться с «потоками» данных. Эти данные поступают непрерывным потоком, часто из нескольких источников одновременно. Хотя, безусловно, можно хранить эти потоки данных на диске и анализировать их ретроспективно, иногда может быть разумно или важно обрабатывать данные и действовать в соответствии с ними по мере их поступления. Например, потоки данных, связанных с финансовыми транзакциями, могут обрабатываться в режиме реального времени для выявления и отклонения потенциально мошеннических транзакций.

Хотя, безусловно, можно хранить эти потоки данных на диске и анализировать их ретроспективно, иногда может быть разумно или важно обрабатывать данные и действовать в соответствии с ними по мере их поступления. Например, потоки данных, связанных с финансовыми транзакциями, могут обрабатываться в режиме реального времени для выявления и отклонения потенциально мошеннических транзакций.

Машинное обучение: По мере роста объемов данных подходы к машинному обучению становятся все более доступными и точными. Программное обеспечение можно обучить идентифицировать и реагировать на триггеры в хорошо понятных наборах данных, прежде чем применять те же решения к новым и неизвестным данным. Способность Spark хранить данные в памяти и быстро выполнять повторяющиеся запросы делает его хорошим выбором для обучения алгоритмов машинного обучения. Выполнение схожих запросов снова и снова в масштабе значительно сокращает время, необходимое для просмотра набора возможных решений, чтобы найти наиболее эффективные алгоритмы.

Интерактивная аналитика: Вместо выполнения предварительно заданных запросов для создания статических информационных панелей продаж или производительности производственных линий или цен на акции бизнес-аналитики и специалисты по данным хотят исследовать свои данные, задавая вопросы, просматривая результат, а затем либо слегка изменив первоначальный вопрос или углубившись в результаты. Для этого интерактивного процесса запросов требуются такие системы, как Spark, способные быстро реагировать и адаптироваться.

Интеграция данных: Данные, создаваемые различными системами предприятия, редко бывают достаточно точными или непротиворечивыми, чтобы их можно было легко и просто объединить для составления отчетов или анализа. Процессы извлечения, преобразования и загрузки (ETL) часто используются для извлечения данных из разных систем, их очистки и стандартизации, а затем загрузки в отдельную систему для анализа. Spark (и Hadoop) все чаще используются для сокращения затрат и времени, необходимых для этого процесса ETL.

Кто использует Spark?

Многие поставщики технологий быстро поддержали Spark, увидев возможность расширить свои существующие продукты для работы с большими данными в областях, где Spark обеспечивает реальную ценность, таких как интерактивные запросы и машинное обучение. Известные компании, такие как IBM и Huawei, инвестировали значительные суммы в эту технологию, и все больше стартапов создают бизнес, полностью или частично зависящий от Spark. Например, в 2013 году команда Беркли, ответственная за создание Spark, основала Databricks, которая предоставляет размещенную сквозную платформу данных на базе Spark. Компания хорошо финансируется, получив 247 миллионов долларов США в ходе четырех раундов инвестиций в 2013, 2014, 2016 и 2017 годах, и сотрудники Databricks продолжают играть заметную роль в улучшении и расширении открытого исходного кода проекта Apache Spark.

Основные поставщики Hadoop, включая MapR, Cloudera и Hortonworks, перешли на поддержку Spark на основе YARN наряду со своими существующими продуктами, и каждый поставщик работает над повышением ценности для своих клиентов. В других местах IBM, Huawei и другие вложили значительные средства в Apache Spark, интегрируя его в свои собственные продукты и внося улучшения и расширения в проект Apache. Веб-компании, такие как китайская поисковая система Baidu, оператор электронной коммерции Taobao и компания социальных сетей Tencent, все осуществляют операции на основе Spark в масштабе, при этом 800 миллионов активных пользователей Tencent, по сообщениям, генерируют более 700 ТБ данных в день для обработки. кластер из более чем 8000 вычислительных узлов.

В других местах IBM, Huawei и другие вложили значительные средства в Apache Spark, интегрируя его в свои собственные продукты и внося улучшения и расширения в проект Apache. Веб-компании, такие как китайская поисковая система Baidu, оператор электронной коммерции Taobao и компания социальных сетей Tencent, все осуществляют операции на основе Spark в масштабе, при этом 800 миллионов активных пользователей Tencent, по сообщениям, генерируют более 700 ТБ данных в день для обработки. кластер из более чем 8000 вычислительных узлов.

В дополнение к этим веб-гигантам, фармацевтическая компания Novartis зависит от Spark, чтобы сократить время, необходимое для передачи данных моделирования в руки исследователей, обеспечивая при этом соблюдение этических и договорных гарантий.

Что отличает Spark?

Существует множество причин для выбора Spark, но следующие три являются ключевыми:

Простота: Возможности Spark доступны через набор многофункциональных API-интерфейсов, разработанных специально для быстрого и простого взаимодействия с данными в любом масштабе. Эти API хорошо задокументированы и структурированы таким образом, что специалисты по данным и разработчики приложений могут быстро запустить Spark в работу.

Эти API хорошо задокументированы и структурированы таким образом, что специалисты по данным и разработчики приложений могут быстро запустить Spark в работу.

Скорость: Spark рассчитан на скорость, работает как в памяти, так и на диске. Используя Spark, команда из Databricks разделила первое место с командой из Калифорнийского университета в Сан-Диего в бенчмаркинге Daytona GraySort 2014 года (https://spark.apache.org/news/spark-wins-daytona-gray). -sort-100tb-benchmark.html). Задача включает обработку статического набора данных; команда Databricks смогла обработать 100 терабайт данных, хранящихся на твердотельных накопителях, всего за 23 минуты, а предыдущему победителю потребовалось 72 минуты с помощью Hadoop и другой конфигурации кластера. Spark может работать еще лучше при поддержке интерактивных запросов данных, хранящихся в памяти. В таких ситуациях утверждают, что Spark может быть в 100 раз быстрее, чем MapReduce от Hadoop.

Поддержка: Spark поддерживает ряд языков программирования, включая Java, Python, R и Scala. Spark поддерживает тесную интеграцию с рядом ведущих решений для хранения данных в экосистеме Hadoop и за ее пределами, включая HPE Ezmeral Data Fabric (файловая система, база данных и хранилище событий), Apache Hadoop (HDFS), Apache HBase и Apache Cassandra. Кроме того, сообщество Apache Spark большое, активное и международное. Растущий набор коммерческих поставщиков, включая Databricks, IBM и всех основных поставщиков Hadoop, обеспечивает всестороннюю поддержку решений на основе Spark.

Spark поддерживает тесную интеграцию с рядом ведущих решений для хранения данных в экосистеме Hadoop и за ее пределами, включая HPE Ezmeral Data Fabric (файловая система, база данных и хранилище событий), Apache Hadoop (HDFS), Apache HBase и Apache Cassandra. Кроме того, сообщество Apache Spark большое, активное и международное. Растущий набор коммерческих поставщиков, включая Databricks, IBM и всех основных поставщиков Hadoop, обеспечивает всестороннюю поддержку решений на основе Spark.

Сила конвейеров данных

Сила Spark во многом заключается в его способности объединять самые разные методы и процессы в единое согласованное целое. За пределами Spark отдельные задачи по выбору данных, преобразованию этих данных различными способами и анализу преобразованных результатов могут легко потребовать ряда отдельных платформ обработки, таких как Apache Oozie. Spark, с другой стороны, предлагает возможность комбинировать их вместе, преодолевая границы между пакетными, потоковыми и интерактивными рабочими процессами таким образом, чтобы сделать пользователя более продуктивным.

Задания Spark последовательно выполняют несколько операций в памяти и переносят их на диск только в том случае, если этого требуют ограничения памяти. Spark упрощает управление этими разрозненными процессами, предлагая единое целое — конвейер данных, который проще настроить, запустить и обслуживать. В таких случаях использования, как ETL, эти конвейеры могут стать чрезвычайно богатыми и сложными, объединяя большое количество входных данных и широкий спектр шагов обработки в единое целое, которое последовательно обеспечивает желаемый результат.

Spark Engine Вопросы и ответы #1

Автор: unknownworlds 13 лет назад

Нам часто задают вопросы о технологии, которую мы разрабатываем для Natural Selection 2. Имея это в виду, я написал первую из нескольких статей в блоге, чтобы ответить на некоторые из наиболее распространенных и интересные вопросы. Мой первоначальный призыв к вопросам породил довольно много вопросов, которые я намереваюсь подробно рассмотреть, но сначала я начну с двух более общих вопросов.

Андреас спрашивает: Что такое двигатель Spark? Это весь игровой движок или только графическая часть?

Это отличный вопрос для начала. Spark — это весь игровой движок и набор инструментов, которые мы используем для создания Natural Selection 2. Сюда входят графика, звук, сетевое взаимодействие, физика, сценарии, поиск пути и система эффектов (возможно, и другие). Он также включает в себя такие инструменты, как Editor, Builder, Viewer и Cinematic Editor.

Когда мы с Чарли начали работать над Natural Selection 2, мы не планировали строить двигатель. Создание технологий — это большая работа, и также очень сложно создать игру — как с точки зрения игрового процесса, так и с точки зрения графики — когда движок еще не закончен. Когда мы окончательно решили, что собираемся создать собственный движок, мы хотели убедиться, что технология достаточно гибкая, чтобы нам не пришлось начинать с нуля для следующей игры. Мы также хотели убедиться, что другие люди могут использовать наш движок для создания собственных игр. С этой целью технология разработана так, чтобы быть в значительной степени независимой от игры. Spark написан на C++ и предоставляет основные функции управления виртуальным миром. Но Natural Selection 2, который полностью запрограммирован на Lua, добавляет общие элементы шутеров от первого лица (игроки, оружие, счет и т. д.) и характерные для Natural Selection элементы, такие как режим командира, деревья технологий, ходьба по стенам и т. д.

С этой целью технология разработана так, чтобы быть в значительной степени независимой от игры. Spark написан на C++ и предоставляет основные функции управления виртуальным миром. Но Natural Selection 2, который полностью запрограммирован на Lua, добавляет общие элементы шутеров от первого лица (игроки, оружие, счет и т. д.) и характерные для Natural Selection элементы, такие как режим командира, деревья технологий, ходьба по стенам и т. д.

Разделение труда при кодировании всегда было очень простым — Чарли пишет код Natural Selection 2, а я пишу код движка/инструментов. Несколько месяцев назад Курт Миллер, отличный программист и мой хороший друг, присоединился к Unknown Worlds, чтобы также работать над кодом движка и инструментов.

В течение последних двух месяцев мы выпускали еженедельные исправления для редактора. Часто люди интерпретируют эти специфичные для редактора обновления как отсутствие прогресса в игре. На самом деле, даже когда мы усердно трудились над редактором — прямо перед первоначальным релизом — Чарли все еще полностью посвятил себя коду игры. Сейчас мы с Куртом тратим большую часть времени на совершенствование движка, а Курт тратит небольшую часть своего времени на внедрение новых функций и исправление ошибок в редакторе.

Сейчас мы с Куртом тратим большую часть времени на совершенствование движка, а Курт тратит небольшую часть своего времени на внедрение новых функций и исправление ошибок в редакторе.

Beat Wolf спрашивает: Какие платформы будут поддерживаться? (Linux, OS X, XBox и т. д.) На веб-странице по-прежнему упоминаются Linux и OS X в качестве целевых платформ, но было много сомнений по поводу включения Steamworks, а также потому, что этот вопрос, похоже, уже некоторое время не рассматривается.

Что ж, пусть проблемы больше не будет! В настоящее время наш движок и инструменты работают только на Windows, и это будет единственная платформа, на которой Natural Selection 2 будет доступна при выпуске. Однако большая часть движка не зависит от платформы. Самая большая часть, специфичная для Windows, — это низкоуровневый код рендеринга, построенный на Direct3D. В интересах того, чтобы наш движок когда-нибудь работал на Linux и OS X, этот низкоуровневый код рендеринга упакован так, что он в основном отделен от остальной части движка. Приложив небольшие усилия, мы можем заменить эту часть реализацией OpenGL, которая будет работать на Linux и OS X. Все наши инструменты построены с использованием кроссплатформенной инфраструктуры wxWidgets, поэтому, как только мы заставим движок работать на другой платформе , принести инструменты не составит особого труда.

Приложив небольшие усилия, мы можем заменить эту часть реализацией OpenGL, которая будет работать на Linux и OS X. Все наши инструменты построены с использованием кроссплатформенной инфраструктуры wxWidgets, поэтому, как только мы заставим движок работать на другой платформе , принести инструменты не составит особого труда.

Теперь, когда я убедил вас, что мы предприняли шаги, чтобы позволить нам перенести наш движок на другие платформы, вы можете задаться вопросом, почему бы нам просто не пойти дальше и не сделать это. Ответ прост; у нас сейчас нет времени. В качестве альтернативы тому, чтобы делать это самостоятельно, мы рассмотрели «открытый исходный код» или публикацию низкоуровневых API-интерфейсов для частей, специфичных для Windows, и пригласили членов сообщества внести свой собственный вклад. Если вам нравится эта идея, дайте мне знать в комментариях.